|

|

|

|||

| WebMoney: WMZ Z294115950220 WMR R409981405661 WME E134003968233 |

Visa 4274 3200 2453 6495 |

|

|

|

|||

| WebMoney: WMZ Z294115950220 WMR R409981405661 WME E134003968233 |

Visa 4274 3200 2453 6495 |

NDB Cluster поддерживает асинхронную

репликацию, чаще упомянутую просто как

репликация.

Эта секция объясняет, как настроить и управлять конфигурацией, в которой одна

группа компьютеров, работающих как NDB Cluster,

копирует к второму компьютеру или группе компьютеров.

Предполагается, что читатель знаком с репликацией MySQL

(см. Replication). NDB Cluster не поддерживает репликацию, используя GTID, полусинхронная

репликация также не поддерживается в Нормальная репликация включает

ведущий и ведомый

серверы. Ведущий является источником операций и данных, которые будут

копироваться, ведомый является получателем. В NDB Cluster

репликация концептуально очень похожа, но может быть более сложна на

практике, поскольку это может быть расширено, чтобы покрыть много различных

конфигураций, включая репликацию между двумя полными кластерами.

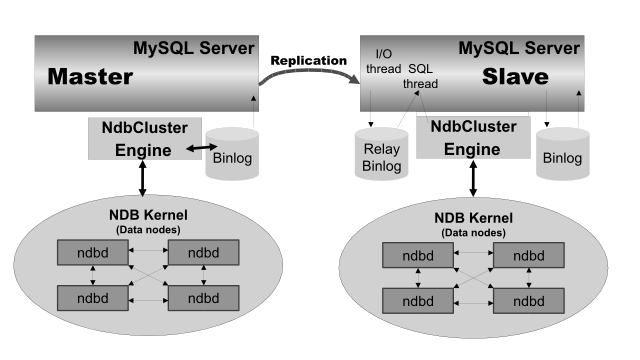

Хотя сам NDB Cluster зависит от

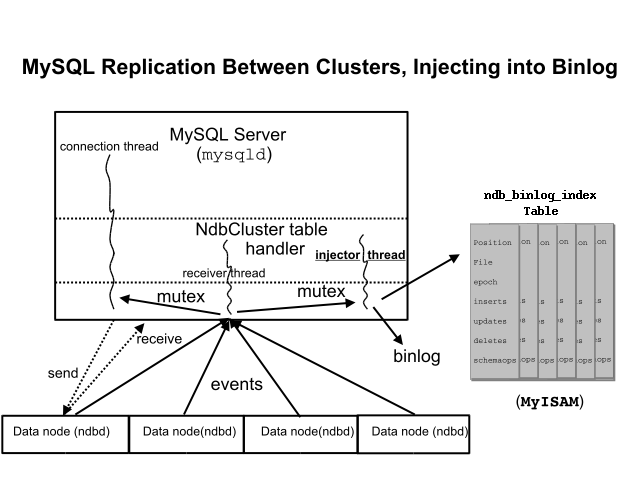

Рис. 8.1. NDB Cluster-to-Cluster Replication В этом сценарии процесс репликации

тот, в котором последовательные статусы основного кластера зарегистрированы и

сохранены к ведомому. Этот процесс достигается специальным потоком, известным

как двоичный поток инжектора регистрации NDB, который работает

на каждом сервере MySQL и производит регистрацию

( Для получения информации о выполнении восстановления момента времени NDB

Cluster и NDB Cluster Replication см.

главу 8.9.2. Переменные статуса NDB API _slave.

NDB API может обеспечить увеличенные контролирующие возможности на ведомых

репликации NDB Cluster. Они осуществляются как статистика переменных статуса

NDB Репликация от NDB до не-NDB таблиц. Возможно копировать

таблицы Всюду по этой секции мы используем следующие сокращения или символы для

обращения к группам ведущего и ведомого, к процессам и командам, которыми

управляют на узлах группы: Таблица 8.1. Аббревиатуры и символы Канал репликации требует двух серверов MySQL, действующих как серверы

репликации (один для ведущего и ведомого). Например, это означает, что в

случае установки репликации с двумя каналами репликации (чтобы обеспечить

дополнительный канал для избыточности), будет в общей сложности четыре узла

репликации (по два на кластер). Репликация NDB Cluster зависит от построчной репликации. Это означает, что

ведущий сервер репликации MySQL должен работать с

При попытке использовать репликацию NDB Cluster с

Значение по умолчанию для

Каждый сервер MySQL, используемый для репликации в любой группе, должен

быть однозначно определен среди всех серверов репликации MySQL, участвующих в

любой группе (у вас не может быть серверов репликации ведущего и ведомого

кластеров, разделяющих тот же самый ID).

Это может быть сделано, начав каждый узел SQL, используя опцию

Вообще верно в MySQL Replication, что оба сервера MySQL

(процессы mysqld)

должны быть совместимыми друг с другом относительно версии используемого

протокола репликации и относительно наборов функций SQL, которые

они поддерживают (см.

здесь). Это происходит из-за таких различий в NDB Cluster

и MySQL Server 5.7, что у NDB Cluster Replication

есть дополнительное требование, чтобы оба

mysqld произошли из

дистрибутива NDB Cluster. Самый простой и самый легкий способ гарантировать,

что серверы mysqld

совместимы, состоит в том, чтобы использовать тот же самый дистрибутив NDB

Cluster для ведущего и ведомого

mysqld. Мы предполагаем, что ведомый сервер

заняты только репликацией ведущего, и что никакие другие данные не

хранятся на нем. Все реплицируемые таблицы Возможно копировать NDB Cluster, используя основанную на запросе

репликацию. Однако в этом случае следующие ограничения применяются: Все обновления строк данных в кластере, действующем как ведущий,

должны быть направлены к единственному серверу MySQL. Невозможно копировать кластер, используя многократные одновременные

процессы репликации MySQL. Только изменения, внесенные на уровне SQL, копируются. Это в дополнение к другим ограничениям основанной на запросе

репликации в противоположность построчной репликации, посмотрите

see здесь для более определенной информации относительно

различий между двумя форматами репликации. Эта секция обсуждает известные проблемы в

репликации с NDB Cluster 7.5. Потеря связи.

Потеря связи может произойти между ведущим репликации узлом SQL и ведомым

репликации узлом SQL или между ведущим репликации узлом SQL и узлами данных в

основном кластере. В последнем случае это может произойти не только в

результате потери физической связи (например, сломанный сетевой кабель), а

из-за переполнения буферов событий узла данных,

если узел SQL также не спешит отвечать, он может быть пропущен кластером

(это управляемо до некоторой степени, приспосабливая параметры

Ведущий репликации выпускает событие gap,

соединяясь или снова соединяясь с основным кластером. Событие gap тип

incident event, которое указывает на инцидент,

который затрагивает содержание базы данных, но это не может легко быть

представлено как строка изменений. Примеры инцидентов: катастрофы сервера,

пересинхронизация базы данных, (немного) обновления программного обеспечения

и (немного) изменения аппаратной конфигурации. Когда ведомый сталкивается с

gap в журнале репликации, это останавливается с сообщением об ошибке.

Это сообщение доступно в выводе

Поскольку NDB Cluster не разработан, чтобы контролировать состояние

репликации или обеспечить отказоустойчивость, если высокая доступность

требование для ведомого сервера или кластера, то необходимо настроить

многократные линии репликации, контролировать основной

mysqld

на основной линии репликации и быть подготовленным перейти к вторичной линии

по мере необходимости. Это должно быть сделано вручную или возможно

посредством стороннего приложения. Для получения информации об осуществлении

этого типа установки посмотрите главы

8.7 и

8.8. Однако, если вы копируете от автономного сервера MySQL в NDB Cluster,

один канал обычно достаточен. Кольцевая репликация.

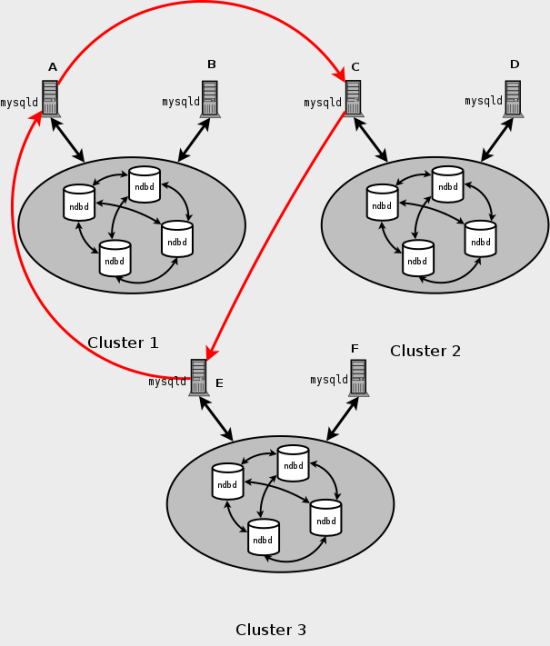

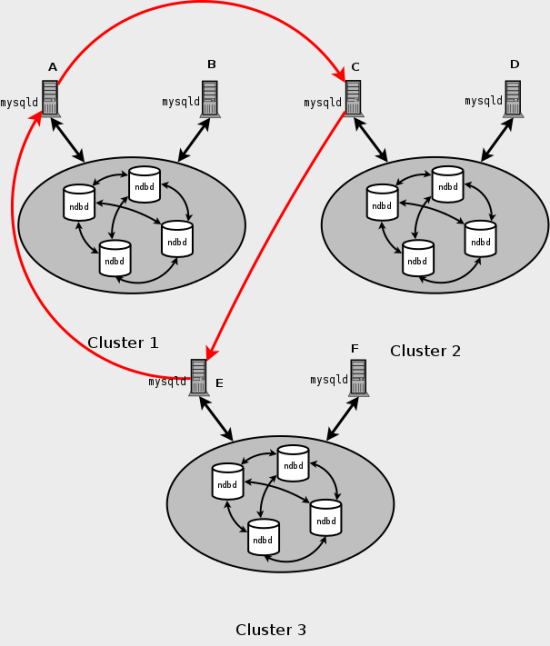

NDB Cluster Replication допускает кольцевую репликацию, как показано

в следующем примере. Установка репликации включает три NDB Clusters 1, 2 и 3,

где Cluster 1 действует как ведущий репликации для Cluster 2, Cluster 2

действует как ведущий репликации для Cluster 3, а Cluster 3 действует как

ведущий репликации для Cluster 1, таким образом заканчивая круг. У каждого

NDB Cluster есть два узла SQL, с узлами SQL A и B, принадлежащими Cluster 1,

узлами SQL C и D, принадлежащими Cluster 2, и узлами

SQL E и F, принадлежащими Cluster 3. Кольцевая репликация, используя эти группы поддерживается, пока

следующим условиям отвечают: Узлы SQL на всех ведущих и ведомых те же самые. Все узлы SQL, действующие как ведущие и ведомые репликации, начаты с

включенной системной переменной

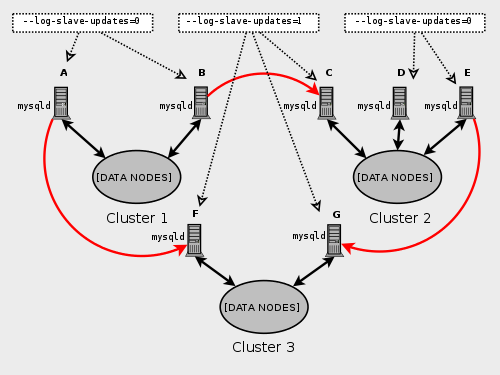

Этот тип кольцевой установки репликации показывают

на следующей диаграмме: Рис. 8.2. Кольцевая репликация NDB Cluster В этом сценарии узел SQL A в Cluster 1 копирует к узлу SQL C в

Cluster 2, узел SQL C копирует к узлу SQL E в Cluster 3, узел

SQL E копирует узлу SQL A. Другими словами, линия репликации (обозначена

кривыми стрелками на диаграмме) непосредственно соединяет все узлы SQL,

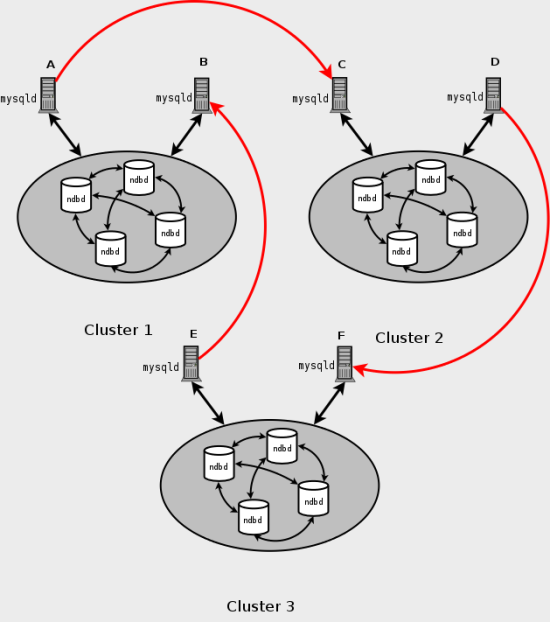

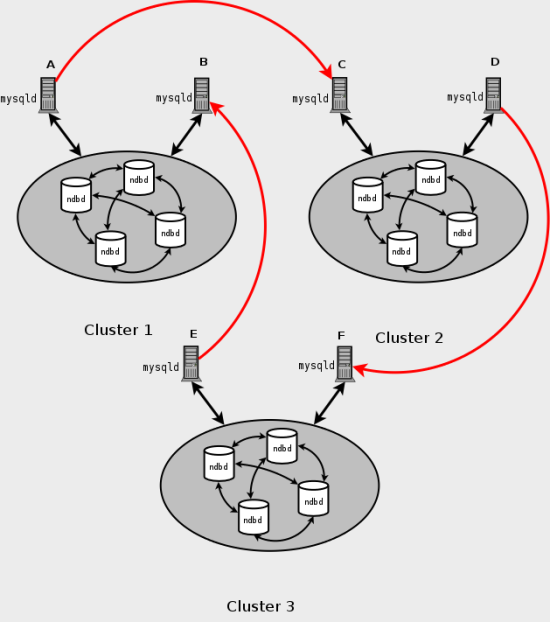

используемые в качестве ведущих и ведомых в репликации. Должно также быть возможно настроить кольцевую репликацию, в которой не

все основные узлы SQL ведомые, как показано здесь: Рис. 8.3. NDB Cluster: другой вариант кольцевой репликации В этом случае различные узлы SQL в каждой группе используются в качестве

ведущих репликации и ведомых. Однако, вы не должны

начинать ни один из узлов SQL с включенной системной переменной

Механизм хранения Репликация NDB Cluster и первичные ключи.

В случае неудачи узла, ошибок в репликации

NDB Cluster Replication и уникальные ключи.

В более старых версиях NDB Cluster

операции, которые обновили значения столбцов уникального ключа таблиц

Отсрочка ограничений таким образом в настоящее время поддерживается

только Проблема есть, когда репликация без отсроченной проверки обновлений

уникального ключа может быть иллюстрирована, используя таблицу

Однако то же самое потерпит неудачу с ошибкой дублирования ключа или

другим ограничительным нарушением на ведомом, потому что порядок

обновлений строки был сделан для одного разделения за один раз, а не

для таблицы в целом. Каждая таблица GTID не поддерживаются. Репликация используя глобальные ID

транзакции, не совместимые с Многопоточные ведомые не поддержаны.

NDB Cluster не поддерживает многопоточных ведомых и урегулирование связанных

системных переменных, например,

Это вызвано тем, что ведомый может не быть в состоянии отделить

транзакции, происходящие в одной базе данных,

от транзакций в другой, если они написаны в течение той же самой эпохи.

Кроме того, каждая транзакция, обработанная

Перезапуск с --initial.

Перезапуск с

Репликация с NDB на другие механизмы хранения.

Возможно копировать таблицы

Мультиведомая и кольцевая репликация не поддерживаются

(таблицы на ведущем и на ведомом должны использовать

Использование механизма хранения, который не выполняет двоичную

регистрацию для ведомых таблиц, требует специальной обработки. Использование нетранзакционного механизма хранения для ведомых таблиц

также требует специальной обработки. Основной mysqld

должен быть начат с опцией

Следующие несколько параграфов предоставляют дополнительную информацию о

каждой из проблем. Многократные ведущие, не поддержаны, копируя NDB к другим

механизмам хранения. Для репликации из

Кроме того, невозможно формировать больше, чем один канал репликации,

копируя между Репликация NDB к ведомому механизму хранения, который не

выполняет двоичную регистрацию.

При попытке копировать от NDB Cluster к ведомому, который использует механизм

хранения, который не обращается с его собственной двоичной регистрацией,

процесс репликации отвалится с ошибкой

Binary logging not possible ... Statement cannot be

written atomically since more than one engine involved and at

least one engine is self-logging (Error

1595).

Можно обойти проблему одним из следующих способов: Выключите двоичный журнал на ведомом.

Это может быть достигнуто, установив

Измените механизм хранения, используемый для таблицы

the mysql.ndb_apply_status.

Если эта таблица будет использовать механизм, который не обращается с его

собственной двоичной регистрацией, это может также устранить конфликт.

Это может быть сделано, делая такой запрос, как

Отфильтруйте изменения таблицы mysql.ndb_apply_status на

ведомом. Это может быть сделано, начав ведомый узел SQL с

Вы не должны отключать репликацию или двоичную регистрацию

Репликация с NDB на нетранзакционный механизм хранения. Копируя от

Репликация и двоичная регистрация, фильтрующая правила с репликацией

между кластерами NDB. При использовании какой-либо из опций

Применение Применение Используя

Используя Необходимо также помнить, что каждое правило

репликации требует следующего: Собственная опция

Собственная опция

Если вы копируете NDB Cluster

ведомому, который использует механизм хранения кроме

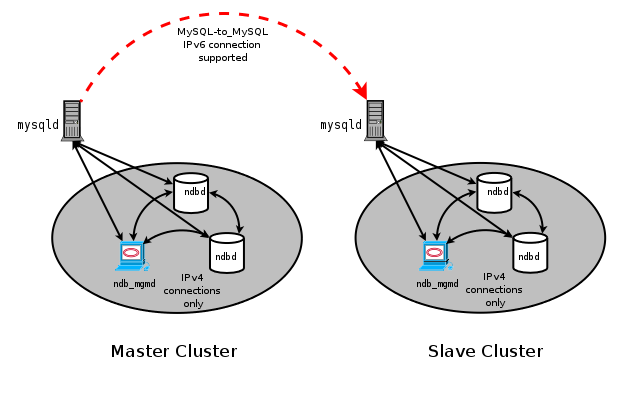

NDB Cluster Replication и IPv6.

Сейчас NDB API и MGM API не поддерживают IPv6. Но MySQL Server

включая тех, которые действуют как узлы SQL в NDB Cluster,

могут использовать IPv6, чтобы связаться с другими MySQL Server.

Это означает, что можно копировать между NDB Cluster, используя IPv6, чтобы

соединить узлы SQL ведущего и ведомого, как показано штриховой

стрелкой в следующей диаграмме: Рис. 8.4. Репликация между узлами SQL, связанными IPv6 Однако все связи, происходящие в

NDB Cluster, представленной в предыдущей диаграмме непрерывными стрелами,

должны использовать IPv4. Другими словами, все узлы данных NDB Cluster,

серверы управления и клиенты управления должны быть доступными друг от друга,

используя IPv4. Кроме того, узлы SQL должны использовать IPv4,

чтобы общаться с группой. В настоящее время нет никакой поддержки в NDB и MGM API для IPv6,

поэтому все приложения с этими API используют именно IPv4. Продвижение и понижение признака. NDB Cluster Replication

включает поддержку продвижения признака.

Внедрение последнего различает преобразования типов,

их использованием на ведомом можно управлять, устанавливая

глобальную системную переменную сервера

См. Row-based replication: attribute

promotion and demotion. Репликация в NDB Cluster использует много специальных таблиц в БД

До NDB 7.5.2 эта таблица всегда использовала механизм

Размер этой таблицы зависит от числа эпох на файл двоичного журнала и

количества двоичных файлов журнала. Число эпох на файл двоичного журнала

обычно зависит от объема двоичной регистрации, произведенной в эпоху и

размера двоичного файла журнала с меньшими эпохами, законченных в большее

количество эпох на файл. Необходимо знать, что пустые эпохи производят

вставки для таблицы Занятый NDB Cluster пишет двоичную регистрацию регулярно и по-видимому

ротирует двоичные файлы журнала более быстро. Это означает, что

тихий NDB Cluster с

Когда mysqld стартует

с опцией

Добавление этого индекса не предоставляет преимущества, копируя от

единственного ведущего единственному ведомому, так как запрос

положения двоичной регистрации в таких случаях не использует

См. главу

8.8 для получения дополнительной информации об использовании колонок

Следующие данные показывают отношения главного сервера репликации NDB

Cluster, его потока инжектора двоичного журнала и таблицы

Рис. 8.5. Replication Master Cluster Дополнительная таблица Таблица Поскольку эта таблица наполнена из

данных, происходящих на ведущем, нужно позволить копировать,

любая фильтрация репликации или двоичной регистрации, фильтрующая правила,

которые непреднамеренно препятствуют тому, чтобы ведомый обновил

Таблицы Однако, желательно проверить существование и целостность этих таблиц как

начальный шаг в подготовке NDB Cluster к репликации.

Возможно рассмотреть данные о событии, зарегистрированные в двоичной

регистрации, запрашивая таблицу

Можно также получить полезную информацию из вывода

Когда выполнение схемы изменяется на таблицы

Если таблицы Разрешение конфликтов для NDB Cluster Replication

требует присутствия дополнительной таблицы

Подготовка NDB Cluster для репликации состоит из следующих шагов: Проверьте все серверы MySQL на совместимость версий (см.

главу 8.2

). Создайте ведомую учетку на основном

кластере с соответствующими привилегиями: В предыдущем запросе

Например, чтобы создать ведомую учетную запись пользователя с именем

Из соображений безопасности предпочтительно использовать уникальную

учетную запись пользователя, не используемую для любой другой

цели для репликации.

Формируйте ведомого, чтобы использовать ведущего. Используя MySQL Monitor,

это может быть достигнуто командой

В предыдущем запросе Например, чтобы сказать ведомому копировать от сервера MySQL, имя хоста

которого Для полного списка вариантов, которые могут использоваться с

этим запросом, посмотрите

CHANGE MASTER TO Statement. Чтобы обеспечить репликацию, также необходимо добавить

Для дополнительных опций, которые могут быть установлены в

Если основная группа уже используется, можно создать резервную копию

ведущего и загрузить ее на ведомого, чтобы сократить количество времени,

требуемое для ведомого, чтобы синхронизировать себя с ведущим. Если ведомый

также управляет NDB Cluster, это может быть достигнуто, используя резервную

копию и процедуру, описанную в

главе 8.9. Если вы не применяете NDB Cluster

на ведомом репликации, можно создать резервную копию этой командой

на ведущем репликации: Импортируйте получающийся дамп данных на ведомого, копируя файл дампа.

После этого можно использовать

mysql,

чтобы импортировать данные из dumpfile в ведомую базу данных как показано

здесь, причем Для полного списка опций

mysqldump см.

mysqldump

A Database Backup Program. Если вы копируете данные ведомому этим способом, необходимо

удостовериться, что ведомый начат с опцией

Гарантируйте, что каждый сервер MySQL, действующий как ведущий

репликации, формируется с уникальным ID сервера и с включеной двоичной

регистрацией, используя формат строки. См.

Replication Formats.

Эти варианты могут быть установлены в файле

Эта секция обрисовывает в общих чертах процедуру старта репликации

NDB Cluster, используя единственный канал репликации. Начните главный сервер репликации MySQL, дав эту команду: В предыдущем запросе Можно также начать ведущего с

Начните ведомый сервер репликации MySQL как показано здесь: Здесь Необходимо использовать

Необходимо синхронизировать ведомый сервер с двоичной регистрацией

репликации главного сервера. Если двоичная регистрация ранее не работала

на ведущем, выполните следующий запрос на ведомом: Это приказывает ведомому начинать читать двоичную регистрацию ведущего от

отправной точки регистрации. Иначе, то есть, если вы загружаете данные от

ведущего, используя резервную копию, см.

главу 8.8

для получения информации о том, как получить правильные значения, чтобы

использовать для Наконец, необходимо приказать ведомому начинать применять репликация,

дав эту команду в клиенте

mysql

на ведомом репликации: Это также начинает передачу данных от ведущего ведомому. Также возможно использовать два канала репликации способом, подобным

процедуре, описанной в следующей секции, различия между этим и использованием

единственного канала репликации рассмотрены в

главе 8.7. Также возможно улучшить производительность репликации, позволяя

пакетные обновления.

Это может быть достигнуто, установив системную переменную

Ведомый комплектует пакеты на основе эпохи:

обновления, принадлежащие больше, чем одной транзакции, можно послать как

часть того же самого пакета. Все обновления применяются, когда конец эпохи достигнут, даже если общее

количество обновлений меньше 32 КБ. Группирование может быть включено во время выполнения.

Чтобы активировать его во время выполнения, можно использовать любой из

этих двух запросов: Если конкретный пакет вызывает проблемы (такие как запрос, эффекты

которого, кажется, не копируются правильно), пакетирование

может быть дезактивировано, используя любой из следующих запросов: Можно проверить, используется ли пакетирование

в настоящее время, посредством соответствующего

В более полном сценарии в качестве примера мы предполагаем два канала

репликации, чтобы обеспечить избыточность и таким образом принять меры против

возможного отказа единственного канала репликации. Это требует в общей

сложности четырех серверов репликации, двух ведущих для основной группы и

двух ведомых серверов для ведомой группы. В целях обсуждения мы предполагаем,

что уникальные идентификаторы назначены как показано здесь: Таблица 8.2. Сервера репликации NDB Cluster Подготовка репликации с двумя каналами не сильно

отличается от подготовки единственного канала репликации. Во-первых, процессы

mysqld

для основных и вторичных ведущих репликации должны начинаться, сопровождаемые

теми же процессами для основных и вторичных ведомых. Тогда процессы

репликации могут быть начаты командой

Начните основного ведущего репликации: Начните вторичного ведущего репликации: Начните основной ведомый сервер репликации: Начните вторичного ведомого репликации: Наконец, начните репликацию на основном канале, выполнив

Только основной канал должен быть начат в этом пункте.

Вторичный канал репликации должен быть начат только, если основной канал

репликации терпит неудачу, как описано в

главе 8.8.

Управление многократными каналами репликации одновременно может привести к

нежелательным записям, создаваемым на ведомых репликации. Как упомянуто ранее, необязательно включать двоичный журнал

на ведомых репликации. Если основной процесс репликации терпит неудачу, возможно переключиться на

вторичный канал репликации. Следующая процедура описывает шаги для этого.

Получите время новой глобальной контрольной точки (GCP). Таким образом,

необходимо определить новую эпоху из таблицы

В кольцевой топологии репликации, с ведущим и ведомым

на каждом хосте, когда вы используете

В этом случае необходимо определить последнюю эпоху на этом ведомом,

исключая любые эпохи от любых других ведомых в двоичной регистрации этого

ведомого, которые не были перечислены в опции

В некоторых случаях может быть более простым или более эффективным

использовать список ID серверов, которые будут включены и

Используя информацию, полученную из запроса, показанного в шаге 1,

получите соответствующие записи из таблицы

Можно использовать следующий запрос, чтобы получить необходимые записи

от таблицы Это сохранено на ведущем, начиная с отказа основного канала репликации.

Мы использовали пользовательскую переменную

Необходимо гарантировать, что ведомый

mysqld запущен с опцией

Теперь возможно синхронизировать вторичный канал, управляя следующим

запросом на вторичном ведомом сервере: Снова мы использовали пользовательские переменные (в этом случае

Можно теперь начать репликацию на вторичном канале, дав

соответствующую команду на вторичном ведомом

mysqld: Как только вторичный канал репликации активен, можно исследовать неудачу

для ремонтных работ. Вторичный канал репликации должен быть начат, только если и когда основной

канал репликации потерпел неудачу. Управление многократными каналами

репликации одновременно может привести к нежелательным дубликатам

записей, создаваемым на ведомых репликации. Если неудача ограничивается единственным сервером, должно быть (в теории)

возможно копировать от

Эта секция обсуждает резервные копии и восстановление от них, используя

репликацию NDB Cluster. Мы предполагаем, что сервера репликации уже

формировались, как покрыто ранее (см.

главу 8.5).

Процедура чтобы сделать резервную копию и затем восстановить

от нее, следующие: Есть два различных метода, которыми может быть

начата резервная копия. Метод A. Этот метод требует, чтобы процесс резервного

копирования группы был ранее позволен на главном сервере до старта процесса

репликации. Это может быть сделано включением следующей строки в раздел

Номер порта должен быть определен, только если порт по умолчанию (1186)

не используется. Посмотрите

главу 4.5.

В этом случае резервная копия может быть начата, выполнив этот

запрос на ведущем репликации: Метод B. Если файл

В нашем сценарии, как обрисовано в общих чертах ранее (см.

главу 8.5),

это было бы выполнено следующим образом: Скопируйте резервные файлы группы ведомому. Каждой системе,

управляющей процессом

ndbd

для основной группы, определят местонахождение резервных файлов и

все эти файлы должны быть скопированы

ведомому, чтобы гарантировать успешное восстановление.

Резервные файлы могут быть скопированы в любой каталог на компьютере, где

находится ведомый хост управления, пока MySQL и NDB имеют право на чтение

этого каталога. В этом случае мы предположим, что эти файлы были скопированы

в каталог Не необходимо, чтобы у ведомой группы было то же самое количество

процессов

ndbd

(узлы данных) как у ведущей, однако, это настоятельно рекомендовано.

Надо, чтобы ведомый был начат с опцией

Создайте любые базы данных на ведомой группе, которые присутствуют на

основной группе и должны копироваться ведомой. Перезагрузите ведомую группу, используя этот

запрос в MySQL Monitor: Можно теперь начать процесс восстановления группы на ведомом

репликации, используя команду

ndb_restore

для каждого резервного файла в свою очередь. Для первого из них

необходимо включить опцию Для восстановления от основной группы с четырьмя узлами данных (как

показано в главе 8), где резервные файлы были

скопированы к каталогу Теперь необходимо получить новую эпоху из таблицы

Используя Если в настоящее время нет никакого трафика репликации, можно получить

эту информацию, выполняя

Используя значения, полученные в предыдущем шаге,

можно теперь выполнить

Теперь, когда ведомый знает

от какой точки в котором файле двоичного журнала начать читать данные от

ведущего, можно заставить ведомого начинать копировать этим

стандартным запросом MySQL: Чтобы выполнить резервную копию и восстановление

на втором канале репликации, необходимо только повторить эти шаги, заменяя

имена хоста и ID вторичного ведущего и ведомого для основных серверов

репликации ведущего и ведомого в соответствующих случаях

и управляя предыдущими запросами на них. Для получения дополнительной информации о резервных копиях и

восстановлении кластера из резервных копий посмотрите

главу 7.3. Возможно автоматизировать большую часть процесса, описанного в

предыдущей секции (см.

главу 8.9).

Следующий скрипт на Perl Восстановление момента времени то есть,

восстановление изменений данных, внесенных начиная с данного момента времени,

выполняется после восстановления полного резервного копирования, которое

возвращает сервер в его состояние, когда резервная копия была сделана.

Выполнение восстановления момента времени таблиц NDB Cluster с

NDB Cluster Replication может быть достигнуто, используя локальную резервную

копию Чтобы выполнить восстановление момента времени NDB Cluster,

необходимо выполнить шаги, показанные здесь: Зарезервируйте все БД В некотором более позднем пункте, до восстановления,

делают резервную копию таблицы

Эта резервная копия должна быть обновлена регулярно, возможно, даже каждый

час, в зависимости от ваших потребностей.

Катастрофический отказ или ошибка происходят. Определите местонахождение последней известной

хорошей резервной копии. Очистите файловые системы узла данных (используя

ndbd

Табличное пространство NDB Cluster Disk Data

и файлы журнала не удалены

Используйте

Выполните

ndb_restore,

восстановив все данные. Необходимо включать опцию

Восстановите таблицу Найдите эпоху, примененную последний раз, то есть, максимум

столбца Найдите последний файл журнала

( С помощью mysqlbinlog

переиграйте двоичные события регистрации от файла и положения до сбоя

(см. mysqlbinlog).

См. также

Point-in-Time (Incremental) Recovery Using the Binary Log

для получения дополнительной информации о двоичной регистрации,

репликации и возрастающем восстановлении. Возможно использовать NDB Cluster в репликации с несколькими ведущими,

включая кольцевую репликацию между многими NDB Cluster. Пример кольцевой репликации.

В следующих нескольких параграфах мы полагаем, что пример установки

репликации, включающей три NDB Cluster 1, 2 и 3, где Cluster 1

действует как ведущий репликации для Cluster 2, Cluster 2 для Cluster 3 и

Cluster 3 для Cluster 1. У каждого кластера есть два узла SQL, с узлами SQL

A и B в Cluster 1, C и D в Cluster 2, E и F в Cluster 3. Кольцевая репликация, используя эти группы поддерживается, пока

следующим условиям отвечают: Узлы SQL на всех ведущих и ведомых то же самое. Все узлы SQL, действующие как ведущие репликации и ведомые, начаты с

включенной системной переменной

Этот тип кольцевой установки репликации показывают

на следующей диаграмме: Рис. 8.6. Кольцевая репликация NDB Cluster В этом сценарии узел SQL A в Cluster 1 копирует к узлу SQL C в

Cluster 2, узел SQL C к узлу SQL E в Cluster 3, а узел

SQL E к узлу SQL A. Другими словами, линия репликации (обозначена

кривыми стрелками на диаграмме) непосредственно соединяет все узлы SQL,

используемые в качестве ведущих репликации и ведомых. Также возможно настроить кольцевую

репликацию таким способом, что не все основные узлы SQL также ведомые,

как показано здесь: Рис. 8.7. Другая кольцевая репликация NDB Cluster В этом случае различные узлы SQL в каждой группе используются в качестве

ведущих репликации и ведомых. Однако, вы не должны

not

начинать ни один из узлов SQL с включенной системной переменной

Применение резервирования и восстановления NDB, чтобы инициализировать

ведомый NDB Cluster.

Настраивая кольцевую репликацию, возможно инициализировать ведомый кластер

при помощи клиента управления (команда Это известная проблема, которую мы намереваемся

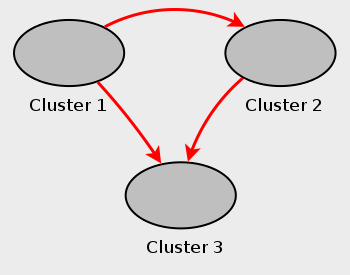

решить в будущем выпуске. Пример отказоустойчивости.

В этой секции мы обсуждаем отказоустойчивость в мультиустановке репликации

NDB Cluster с тремя NDB Cluster, имеющими ID сервера 1, 2 и 3. В этом

сценарии Cluster 1 копирует к Clusters 2 и 3, Cluster 2 тоже копирует к

Cluster 3. Эти отношения показывают здесь: Рис. 8.8. NDB Cluster Multi-Master Replication с 3 ведущими Другими словами, данные копируют от Cluster 1 на Cluster 3

через 2 различных маршрута: непосредственно и посредством Cluster 2. Не все серверы MySQL

должны действовать как ведущий и как ведомый, и данный NDB Cluster

мог бы использовать различные узлы SQL для различных каналов репликации.

Такой случай показывают здесь: Рис. 8.9. NDB Cluster Multi-Master Replication с серверами MySQL Серверами MySQL, действующими как ведомые репликации, нужно управлять с

включенной системной переменной

Применение системной переменной

Потребность в отказоустойчивости возникает, когда одна из групп репликации

падает. В этом примере мы рассматриваем случай, где Cluster 1

потерян, таким образом, Cluster 3 теряет 2 источника обновлений от Cluster 1.

Поскольку репликация между NDB Cluster асинхронная, нет никакой гарантии, что

обновления Cluster 3, происходящие непосредственно из Cluster 1,

более свежие, чем полученные через Cluster 2.

Можно обращаться с этим, гарантируя что Cluster 3 предпочтительней Cluster 2

относительно обновлений от Cluster 1.

С точки зрения серверов MySQL это означает, что необходимо копировать любые

обновления от сервера MySQL C к серверу F. На сервере C выполните следующие запросы: Можно улучшить исполнение этого запроса и таким образом, вероятно,

значительно ускорить время отказоустойчивости, добавляя соответствующий

индекс к таблице Скопируйте зачения Как только это было сделано, вы можете скомандовать

Используя установку репликации, вовлекающую много ведущих (включая

кольцевую репликацию) возможно, что различные ведущие могут попытаться

обновить ту же самую строку на ведомом с различными данными. Разрешение

конфликтов в NDB Cluster Replication обеспечивает средство решения таких

конфликтов, разрешая определенной пользователями колонке резолюции

использоваться, чтобы определить, должно ли обновление на данном

ведущем быть применено на ведомом. Некоторые типы разрешения конфликтов поддерживаются NDB Cluster

( Необходимо также иметь в виду, что

обязанность приложения гарантировать, что колонка резолюции правильно

наполнена соответствующими значениями, чтобы функция резолюции могла сделать

соответствующий выбор, определяя, применить ли обновление. Требования. Приготовления к разрешению конфликтов должны быть

сделаны на ведущем и на ведомом. Эти задачи описаны в следующем списке: На ведущем, пишущем двоичные журналы,

необходимо определить, какие колонки посылают (все колонки или только те,

которые были обновлены). Это сделано для MySQL Server в целом, применив

опцию запуска mysqld

Если вы копируете таблицы с очень большими колонками (например,

as См. Replication and max_allowed_packet

для получения дополнительной информации об этой проблеме. На ведомом необходимо определить который тип разрешения

конфликтов применить (latest timestamp wins,

same timestamp wins, primary

wins, primary wins, complete

transaction или none). Это сделано, используя системную таблицу

NDB Cluster также поддерживает прочитанное обнаружение конфликта, то

есть, обнаруживание конфликтов между чтениями

данной строки в одном кластере и обновлением или удалением той же самой

строки в другом кластере. Это требует исключительных блокировок чтения,

полученных, устанавливая

Используя функции Функции Основной контроль за колонкой.

Мы видим операции по обновлению с точки зрения образов

до и после

то есть, статусов таблицы прежде и после того, как обновление будет

применено. Обычно, обновляя таблица с первичным ключом, образ

до не очень интересен, однако, когда мы должны

определить на основе обновления, использовать ли обновленные значения на

ведомом репликации, мы должны удостовериться, что оба образа написаны в

двоичный журнал ведущего. Это сделано с опцией

Сделана ли регистрация полных строк или только обновленных

колонок, решено, когда сервер MySQL начат и не может быть изменено онлайн,

необходимо перезапустить mysqld

или начать новый экземпляр mysqld

с иным вариантом регистрации.

В целях разрешения конфликтов есть два основных метода регистрации

строк, как определено урегулированием опции

Регистрация полных строк. Зарегистрируйте только данные о колонке, которые были обновлены, то

есть данные о колонке, значение которой было установлено, независимо от того,

было ли это значение на самом деле изменено. Это поведение по умолчанию.

Это обычно достаточно и более эффективно зарегистрировать только

обновленные колонки, однако, если необходимо зарегистрировать полные строки,

можно сделать так, установив

Настройка MySQL Server

Чтобы выключить выбор, начните основной

mysqld с

Контроль за разрешением конфликтов.

Разрешение конфликтов обычно позволяется на сервере, где конфликты могут

произойти. Как выбор метода журналирования, это позволено записями в

таблице

Системная таблица ndb_replication.

Чтобы позволить разрешение конфликтов, необходимо создать таблицу

Колонки в этом таблице описаны в следующих нескольких параграфах. db. Название базы данных, содержащей таблицу, которая будет

копироваться. Можно использовать любой или оба из подстановочных знаков

table_name. Название таблицы, которая будет копироваться.

Имя таблицы может включать любой или оба из подстановочных знаков

server_id. Уникальный ID сервера MySQL (узла SQL),

где таблица находится. binlog_type. Тип двоичного журнала.

Это определяется как показано в следующей таблице: Таблица 8.3. Значения binlog_type

с внутренними значениями и описаниями conflict_fn. Функция разрешения конфликтов, которая будет

применена. Эта функция должна быть определена как одно из показанных в

следующем списке значений: Эти функции описаны в следующих нескольких параграфах.

NDB$OLD(column_name).

Если значение

Эта функция может использоваться для разрешения конфликтов

same value wins.

Этот тип разрешения конфликтов гарантирует, что обновления не применяются

на ведомом от неправильного ведущего. Значение столбца от образа ведущего до

используется этой функцией.

NDB$MAX(column_name).

Если значение столбца timestamp

для данной строки, прибывающей от ведущего, выше, чем это на ведомом, оно

применяется, иначе это не применяется на ведомом.

Это иллюстрировано следующим псевдокодом:

Эта функция может использоваться для разрешения конфликтов

greatest timestamp wins.

Этот тип разрешения конфликтов гарантирует, что в случае конфликта версия

строки, которая была последний раз обновлена, является

версией, которая сохраняется. Значение столбца от ведущего образа после

используется этой функцией.

NDB$MAX_DELETE_WIN().

Вариант

Эта функция может использоваться для разрешения конфликтов

greatest timestamp, delete wins.

Этот тип разрешения конфликтов гарантирует, что в случае конфликта версия

строки, которая была удалена или последний раз обновлена, является

версией, которая сохраняется. Как с

NDB$EPOCH() и NDB$EPOCH_TRANS().

Функция Большая часть того, что следует в описании

Когда ведомый первичный обнаруживает конфликты, они вводят события в свою

собственную двоичную регистрацию, чтобы дать компенсацию за них,

это гарантирует, что вторичный NDB Cluster

в конечном счете перестраивает себя с первичным и так первичный и вторичный

работают вместе без отклонения.

Этот механизм компенсации и перестройки требует, чтобы основной NDB Cluster

всегда выигрывал любые конфликты со вторичным то есть, что всегда

используются изменения первичного, а не от вторичного в случае конфликта. Эти

правила primary always wins

имеют следующие последствия: Операции, которые изменяют данные, когда-то переданные на

первичном, полностью постоянные и не будут отменены или откачены до прежнего

уровня обнаружением конфликта и резолюцией. Данные, прочитанные из первичного,

полностью последовательны. Любые изменения, переданные на первичном

(в местном масштабе или от ведомого), не изменятся позже. Операции, которые изменяют данные на вторичном, могут позже

измениться, если первичный решает, что они находятся в конфликте. Отдельные строки, прочитанные на вторичном, последовательны в любом

случае, каждая строка всегда отражает статус, переданный вторичным, или

передачу от первичного. Наборы строк, прочитанных на вторичном, могут не обязательно быть

последовательными в данном единственном моменте времени. Для

Принимая период достаточной длины без любых конфликтов, все данные по

вторичному NDB Cluster в конечном счете становятся согласовывающимися с

данными первичного кластера. Каждая из функций Для значений по умолчанию этих параметров конфигурации (2000 и 100

миллисекунд, соответственно), это дает значение 5 битов, таким образом,

значение по умолчанию (6) должно быть достаточным, если другие значения

не используются для

Как с другими функциями обнаружения конфликта, обсужденными в этой секции,

Поскольку алгоритмы обнаружения конфликта, используемые

Конфликт между операциями

Переменные статуса обнаружения конфликта.

Несколько переменных статуса могут использоваться, чтобы контролировать

обнаружение конфликта. Вы видите, сколько строк были найдены в конфликте

См. главу

5.3.9.3.

Ограничения на NDB$EPOCH().

Следующие ограничения в настоящее время применяются, используя

Конфликты обнаружены, используя границы эпохи NDB Cluster

со степенью детализации, пропорциональной

Дополнительное хранение требуется для таблиц, используя функции

Конфликты между операциями удаления

могут привести к расхождению между первичным и вторичным.

Когда строка удалена на обеих группах одновременно, конфликт может быть

обнаружен, но не зарегистрирован, так как строка удалена. Это означает, что

дальнейшие конфликты во время распространения любых последующих операций по

перестройке не будут обнаружены, что может привести к расхождению. Удаление должно быть внешне преобразовано в последовательную форму или

маршрутизировано только к одному кластеру.

Альтернативно отдельная строка должна быть обновлена транзакционно

с таким удалением и любыми вставками, которые следуют за ним, так, чтобы

конфликты могли быть прослежены через удаление строки.

Это может потребовать изменений в запросах. Только два NDB Cluster в кольцевой конфигурации

active-active

в настоящее время поддерживаются, используя

Таблицы со столбцами

NDB$EPOCH_TRANS().

Кроме того, любые транзакции, которые обнаружимо зависят от противоречивой

транзакции, также расцениваются как конфликтные,

определяемые содержанием двоичной регистрации вторичного кластера.

Так как двоичная регистрация содержит только операции по модификации данных

(вставки, обновления и удаления), только накладывающиеся модификации данных

используются, чтобы определить зависимости между транзакциями. См.

NDB$EPOCH() и NDB$EPOCH_TRANS(). Информация о статусе. Переменная статуса сервера

Число раз, которое строка не была применена как результат разрешения

конфликтов same timestamp wins на данном

mysqld

с прошлого раза, когда это было перезапущено, дано глобальной переменной

статуса

NDB$EPOCH2().

Функция

NDB$EPOCH2_TRANS().

Где При использовании Необходимо также знать что, отражая все операции от вторичного назад

первичному увеличивается размер регистрации на первичном, а также требования

к пропускной способности, использованию CPU и дисковому I/O. Применение отраженных операций на вторичном зависит от статуса целевой

строки на вторичном. Применяются ли отраженные изменения на вторичном, может

быть прослежено, проверив переменные статуса

События применяются, если и только если оба из

следующих условий верны: Существование строки то есть, существует ли это в соответствии с

типом события. Для операции удаления и обновления строка должна уже

существовать. Для операций по вставке не должна. Строка была в последний раз изменена первичным.

Возможно, что модификация была достигнута посредством

выполнения отраженной операции. Если оба из условий не соблюдаются, от отраженной

операции отказывается вторичный.

Таблица исключений разрешения конфликтов.

Чтобы использовать функцию разрешения конфликтов

Первые четыре колонки требуются. Названия первых четырех колонок и

колонок, соответствующих колонкам первичного ключа оригинальной таблицы, не

очень важны, однако, мы предлагаем по причинам ясности и последовательности,

что вы используете имена, показанные здесь для столбцов

Если таблица исключений использует одну или больше дополнительных колонок

После этих колонок столбцы, составляющие первичный ключ оригинальной

таблицы, должны быть скопированы в порядке, в котором они используются, чтобы

определить первичный ключ оригинальной

таблицы. Типы данных для колонок, дублирующих колонки первичного ключа

оригинальной таблицы, должны быть таким же (или больше), как первоначальные

столбцы. Подмножество колонок первичного ключа может использоваться. Независимо от используемой версии NDB Cluster,

таблица исключений должна использовать механизм

Дополнительные колонки могут произвольно быть определены после

скопированных колонок первичного ключа, но не перед любой

из них, любые такие дополнительные столбцы не могут быть

Типы операций

Дополнительные справочные колонки, которые не являются частью первичного

ключа оригинальной таблицы, можно назвать

Таблица Следующие примеры предполагают, что у вас уже есть установка репликации

NDB Cluster как описано в главах

8.5 и

8.6.

Пример NDB$MAX(). Предположим, что вы хотите позволить

разрешение конфликтов greatest timestamp

wins на таблице Удостоверьтесь, что вы начали основной

mysqld м

-На ведущем выполните такой

Вставка 0 в

Вставка Создайте таблицу Теперь, когда обновления сделаны на этой

таблице, разрешение конфликтов применяется, и версия строки, имеющей

самую большую значение для Другие варианты

Пример NDB$OLD(). Предположим, что таблица

Следующие шаги требуются в показанном порядке: Сначала ДО создания

Возможные значения для столбца Составьте соответствующую таблицу исключений для

Мы можем включать дополнительные колонки для получения информации о типе,

причине и ID происходящей транзакции для данного конфликта. Мы также не

обязаны поставлять соответствие колонкам для всех колонок первичного ключа в

оригинальной таблице. Это означает, что можно

составить таблицу исключений: Префикс Создайте таблицу Эти шаги должны быть выполнены для каждой таблицы,

для которой вы хотите выполнить использование разрешения конфликтов

Обнаружение конфликта чтения и резолюция.

NDB Cluster также поддерживает отслеживание операций чтения, которое

позволяет в кольцевых установках репликации справиться с конфликтами чтения

данной строки в одной группе и обновлением или удалением той же самой строки

в другом кластере. Этот пример использует таблицы

Таблицы данных были созданы, используя следующие SQL-операторы: Содержание этих двух таблиц включает строки, показанные в (частичном)

выводе следующего запроса

Мы предполагаем, что уже используем таблицу

исключений, которая включает четыре необходимых колонки (и они используются

для первичного ключа этой таблицы), дополнительные колонки для операционного

типа и причины и колонку первичного ключа оригинальной таблицы, созданную с

использованием SQL-оператора, показанного здесь: Предположим там происходят две одновременных транзакции на этих двух

кластерах. В кластере A

мы создаем новый отдел, затем перемещаем сотрудника номер 999 в тот

отдел, используя следующие SQL-операторы: В то же время на кластере B

другая транзакция читает из Противоречивые транзакции обычно не обнаруживаются механизмом разрешения

конфликтов, так как конфликт между чтением

( Конфликт зарегистрирован в таблице исключений (на

A) как операция

Любые существующие строки, найденные в операции чтения, отмечаются.

Это означает, что многократные строки, следующие из того же самого конфликта,

могут войти в таблицу исключений, как показано исследовав эффекты конфликта

между обновлением на кластере A и

чтение многократных строк на кластере

B от той же самой таблицы в

одновременных транзакциях. Транзакцию, выполненную на кластере

A, показывают здесь: Одновременно транзакция, содержащая запросы, показанные здесь, работает на

кластере B: В этом случае все три строки, соответствующие

Отслеживание чтений выполняется только на основе существующих строк.

Чтение на основе данного условия отслеживает конфликты только любых строк,

которые найдены,

а не любых строк, которые вставляются в чередованную транзакцию.

Это подобно тому, как исключительная блокировка строки выполняется в

единственном экземпляре NDB Cluster.

Глава 8. NDB Cluster Replication

NDB.NDB

для объединения в кластеры функциональности, не столь необходимо использовать

NDB

как механизм хранения ведомого для копируемых таблиц (см.

здесь). Однако, для максимальной доступности возможно (и предпочтительно)

копировать от одного NDB Cluster на другой

и именно этот сценарий мы обсуждаем.

binlog). Это гарантирует, что все изменения в

группе, производящей регистрацию (а не только те изменения, которые вызваны

через MySQL Server), вставляются в регистрацию с правильным порядком

преобразования в последовательную форму. Мы обращаемся к ведущему и

ведомым серверам MySQL как к серверам репликации или узлам, поток данных или

линия связи между ними известна как

канал репликации._slave, как замечено в выводе

SHOW STATUS или в

результатах запросов к таблицам

SESSION_STATUS или

GLOBAL_STATUS

в сессии клиента mysql,

связанного с MySQL Server, который действует как ведомый в NDB Cluster

Replication. Сравнивая значения этих переменных статуса прежде и после того,

как выполнение воздействия запросов копируется в таблицы

NDB,

можно наблюдать соответствующие действия на уровне NDB API,

что может быть полезным, контролируя или исследуя NDB Cluster Replication.

Глава 7.17

предоставляет дополнительную информацию.NDB с

NDB Cluster к таблицам, используя другие механизмы хранения MySQL, такие как

InnoDB или

MyISAM на ведомом

mysqld.

Это подчиняется многим условиям, посмотрите

здесь и

здесь.

8.1. NDB Cluster Replication: символы и сокращения

Обозначение

Смысл MГруппа, служащая (основным) ведущим репликации SГруппа, действующая как (основной) ведомый репликации shell

M>Команда, которая будет выполнена на основной группе mysql

M>Команда клиента MySQL, данная на единственном сервере MySQL, работающем

как узел SQL на основной группе mysql

M*>Команда клиента MySQL

на всех узлах SQL, участвующих в группе ведущего репликации shell

S>Команда, которая будет выполнена на ведомой группе mysql

S>Команда клиента MySQL, данная на единственном сервере MySQL, работающем

как узел SQL на ведомой группе mysql

S*>Команда клиента MySQL

на всех узлах SQL, участвующих в ведомой группе репликации CОсновной канал репликации C'Вторичный канал репликации M'Вторичный ведущий репликации S'Вторичный ведомый репликации

8.2. Основные требования для NDB Cluster Replication

--binlog-format=ROW или

--binlog-format=MIXED, как

описано в главе 8.6

. Для получения общей информации о построчной репликации посмотрите

здесь.--binlog-format=STATEMENT

репликация не работает правильно потому, что таблица

ndb_binlog_index на ведущем и столбец

epoch таблицы

ndb_apply_status на ведомом не обновляется (см.

главу 8.4).

Вместо этого только обновления на сервере MySQL, действующем как ведущий

репликации, размножаются ведомому, но никакие обновления от любых других

узлов SQL ведущего кластера не копируются.--binlog-format в NDB 7.5

MIXED.--server-id=

, где idid

уникальное целое число. Хотя это не строго необходимо, мы предположим в целях

этого обсуждения, что все выполняемые модули NDB Cluster

имеют ту же самую версию выпуска.NDB

должны быть составлены, используя сервер MySQL и клиент. Таблицы и другие

объекты базы данных, созданные с использованием API NDB (например,

Dictionary::createTable()),

невидимы серверу MySQL и не копируются. Могут копироваться обновления

приложениями API NDB к существующим таблицам, которые были составлены,

используя сервер MySQL.

8.3. Известные проблемы в NDB Cluster Replication

MaxBufferedEpochs и

TimeBetweenEpochs). Если это происходит,

для новых данных возможно быть вставленными в

основной кластер, не будучи зарегистрированными в двоичном журнале

ведущего репликации. Поэтому, чтобы гарантировать высокую

доступность, чрезвычайно важно поддержать канал репликации резервных данных,

контролировать основной канал и быть в состоянии перейти к вторичному каналу

репликации при необходимости сохранить ведомый кластер

синхронизированным с ведущим. NDB Cluster не разработан, чтобы выполнить

такой контроль самостоятельно, для этого требуется внешнее приложение.SHOW SLAVE STATUS

и указывает, что поток SQL остановился из-за инцидента, зарегистрированного в

потоке репликации, и что ручное вмешательство требуется. Посмотрите

главу 8.8

для получения дополнительной информации о том, что сделать

при таких обстоятельствах.log_slave_updates.

log_slave_updates.

Этот тип кольцевой схемы репликации NDB Cluster, в которой линия репликации

(снова обозначена кривыми стрелками на диаграмме) прерывиста, должен быть

возможным, но нужно отметить, что это полностью еще не проверили и поэтому

все еще считается экспериментальным.NDB

использует идемпотентный способ выполнения,

который подавляет дублирование ключа и другие ошибки, которые иначе ломают

кольцевую репликацию в NDB Cluster. Это эквивалентно урегулированию

глобальной системной переменной

slave_exec_mode в

IDEMPOTENT, хотя это не необходимо в

репликации NDB Cluster, так как NDB Cluster

устанавливает эту переменную автоматически и игнорирует любые

попытки установить ее явно.NDB, таблицы

без первичных ключей могут все еще произойти, из-за возможности

дублирующихся строк, вставляемых в таких случаях.

Поэтому настоятельно рекомендовано всем таблицам

NDB

иметь первичные ключи.NDB,

могли привести к ошибкам дублирования ключа, когда копируются.

Эта проблема решена для репликации между таблицами

NDB, отсрочивая проверки

уникального ключа до окончания всех обновлений строки таблицы.NDB.

Таким образом, обновления уникальных ключей, копируя от

NDB

к различному механизму хранения, такому как

MyISAM или

InnoDB,

все еще не поддерживаются.NDB. Например, таблица

t создается на ведущем (и копируется ведомому,

который не поддерживает отсроченные обновления уникального ключа),

как показано здесь:

CREATE TABLE t (p INT PRIMARY KEY, c INT, UNIQUE KEY u (c)) ENGINE NDB;

INSERT INTO t VALUES (1,1), (2,2), (3,3), (4,4), (5,5);

UPDATE на

t выполняется на ведущем, так как затронутые

строки обрабатываются в порядке, определенном

ORDER BY:

UPDATE t SET c = c - 1 ORDER BY p;

NDB

неявно разделена ключом, когда это создается. Посмотрите

KEY Partitioning.NDB,

и не поддерживается. Предоставление возможности GTID, вероятно, заставит

репликацию NDB Cluster Replication отвалится.slave_parallel_workers,

slave_checkpoint_group и

slave_checkpoint_group

(или аналогичные опции запуска

mysqld) не работают.NDB,

включает по крайней мере две базы данных: целевую и системную

mysql из-за требования для обновления таблицы

mysql.ndb_apply_status (см.

глава 8.4).

Это в свою очередь ломает требование для мультипоточности, что транзакция

определена для данной базы данных.--initial

заставляет последовательность GCI и чисел эпохи начинаться с

0. Это обычно верно для NDB Cluster

и не ограничено сценариями репликации, включающими Cluster.

Серверы MySQL, вовлеченные в репликацию, должны в этом случае быть

перезапущены. После этого необходимо использовать

RESET MASTER и

RESET SLAVE, чтобы очистить

таблицы ndb_binlog_index и

ndb_apply_status.NDB на ведущем к таблицам, используя

иной механизм хранения на ведомом, принимая во внимание

ограничения, перечисленные здесь:NDB для этого).--ndb-log-update-as-write=0 или

--ndb-log-update-as-write=OFF.NDB к иному

механизму хранения отношения между этими двумя базами данных должны быть

просто "главный-подчиненный". Это означает, что кольцевая или

ведущий-ведущий репликация не поддерживается между NDB Cluster

и другими механизмами хранения.NDB

и другим механизмом хранения. Однако, база данных NDB Cluster

может

одновременно копироваться к многим ведомым базам данных NDB Cluster.

Если ведущий использует таблицы

NDB, все еще возможно иметь больше, чем один MySQL Server,

который поддерживает двоичную регистрацию всех изменений.

Однако, для ведомого, чтобы изменить ведущих, новые отношения

"главный-подчиненный" должны быть явно определены на ведомом.sql_log_bin = 0.ALTER TABLE

mysql.ndb_apply_status ENGINE=MyISAM на ведомом.

Безопасно сделать это, используя

не-NDB

механизм хранения на ведомом, так как вы не должны тогда волноваться по

поводу поддержания синхронизированными узлов SQL.

--replicate-ignore-table=mysql.ndb_apply_status.

Если вы должны для других таблиц проигнорировать репликацию, вы могли бы

использовать соответствующую опцию

--replicate-wild-ignore-table.

mysql.ndb_apply_status

или изменять механизм хранения, используемый для этой таблицы, копируя от

одного NDB Cluster к другому. См.

здесь.NDB

к нетранзакционному механизму хранения, такому как

MyISAM,

можно столкнуться с ошибками дублирования ключа, копируя

INSERT ... ON DUPLICATE KEY UPDATE

. Можно подавить их при помощи

--ndb-log-update-as-write=0,

который вынуждает обновления быть зарегистрированными как записи,

а не как обновления.--replicate-do-*,

--replicate-ignore-*,

--binlog-do-db или

--binlog-ignore-db,

чтобы отфильтровать базы данных или копируемые таблицы, нужно соблюдать

осторожность, чтобы не заблокировать репликацию или двоичный журнал

mysql.ndb_apply_status,

что требуется для репликации между NDB Cluster.

В частности необходимо иметь в виду следующее:--replicate-do-db=

(но не других db_name--replicate-do-* или

--replicate-ignore-*), означает что

ТОЛЬКО таблицы в базе данных

db_name

копируются. В этом случае необходимо также использовать

--replicate-do-db=mysql,

--binlog-do-db=mysql или

--replicate-do-table=mysql.ndb_apply_status, чтобы

гарантировать, что mysql.ndb_apply_status

заполнена на ведомых.--binlog-do-db=

(но не других

db_name--binlog-do-db)

означает что изменения только

таблиц в базе данных db_name

написаны двоичной регистрации. В этом случае необходимо также использовать

--replicate-do-db=mysql,

--binlog-do-db=mysql или

--replicate-do-table=mysql.ndb_apply_status,

чтобы гарантировать, что mysql.ndb_apply_status

заполнена на ведомых.--replicate-ignore-db=mysql

значит, что никакие таблицы в БД mysql

не копируются. В этом случае необходимо также использовать

--replicate-do-table=mysql.ndb_apply_status, чтобы скопировать

to ensure that mysql.ndb_apply_status.--binlog-ignore-db=mysql

значит, что никакие изменения таблиц в БД mysql

не написаны двоичной регистрации. В этом случае необходимо также использовать

--replicate-do-table=mysql.ndb_apply_status, чтобы скопировать

mysql.ndb_apply_status.--replicate-do-* или

--replicate-ignore-*

и что многочисленные правила нельзя выразить в единственном выборе фильтрации

репликации. Для получения информации об этих правилах посмотрите

Replication and Binary Logging Options and Variables

.--binlog-do-db или

--binlog-ignore-db

и что многочисленные правила нельзя выразить в единственной двоичной

регистрации, фильтрующей выбор. Для получения информации об этих правилах

посмотрите The Binary Log.NDB,

эти соглашения могут не работать.

slave_type_conversions.NDB, в отличие от

InnoDB или

MyISAM,

не пишет изменения виртуальных колонок в двоичный журнал.

Однако, это не имеет никаких неблагоприятных эффектов на репликацию NDB

Cluster или репликацию между NDB

и другими механизмами хранения. Изменения сохраненных

произведенных колонок зарегистрированы.

8.4. Схема репликации и таблицы NDB Cluster

mysql на каждом MySQL Server, действующим

как узел SQL, в копируемой группе и в ведомом репликации. Эти таблицы

составлены во время процесса установки MySQL и включают таблицу для того,

чтобы хранить данные об индексации двоичной регистрации. Начиная с

ndb_binlog_index

таблицы местные к каждому серверу MySQL и не участвуют в объединении в

кластеры, это использует механизм InnoDB.

Это означает, что должно быть создано отдельно на каждом

mysqld, участвующем в основном

кластере. Однако, сама двоичная регистрация содержит обновления от всех

серверов MySQL в кластере, который будет копироваться.

Эта таблица определяется следующим образом:

CREATE TABLE `ndb_binlog_index` (`Position` BIGINT(20) UNSIGNED NOT NULL,

`File` VARCHAR(255) NOT NULL,

`epoch` BIGINT(20) UNSIGNED NOT NULL,

`inserts` INT(10) UNSIGNED NOT NULL,

`updates` INT(10) UNSIGNED NOT NULL,

`deletes` INT(10) UNSIGNED NOT NULL,

`schemaops` INT(10) UNSIGNED NOT NULL,

`orig_server_id` INT(10) UNSIGNED NOT NULL,

`orig_epoch` BIGINT(20) UNSIGNED NOT NULL,

`gci` INT(10) UNSIGNED NOT NULL,

`next_position` bigint(20) unsigned NOT NULL,

`next_file` varchar(255) NOT NULL,

PRIMARY KEY (`epoch`,`orig_server_id`,

`orig_epoch`)) ENGINE=InnoDB

DEFAULT CHARSET=latin1;

MyISAM.

Если вы модернизируете от более раннего выпуска, можно использовать

mysql_upgrade с опциями

--force и

--upgrade-system-tables,

чтобы заставить его выполнять

ALTER TABLE ...

ENGINE=INNODB на этой таблице. Использование

MyISAM для этой таблицы продолжает

поддерживаться в NDB 7.5.2 и позже для обратной совместимости.ndb_binlog_index

может потребовать дополнительного дискового пространства, будучи

преобразованной в InnoDB.

Если это становится проблемой, можно быть в состоянии сохранить

пространство при помощи табличного пространства

InnoDB для этой таблицы, изменяя

ROW_FORMAT на

COMPRESSED. См.

see CREATE TABLESPACE Statement и

CREATE TABLE Statement, а также

Tablespaces.ndb_binlog_index,

даже когда

--ndb-log-empty-epochs =

OFF,

то есть количество записей на файл зависит от отрезка времени,

которое файл используется.

[Число эпох на файл] = [time spent per file] /

TimeBetweenEpochs

--ndb-log-empty-epochs=ON

может на самом деле иметь намного более высокое количество строк

ndb_binlog_index

на файл, чем кластер с большой деятельностью.--ndb-log-orig,

orig_server_id и

orig_epoch хранят ID сервера, на котором

порождено событие, и эпоху, в которую событие произошло на сервере, что

полезно в установках репликации NDB Cluster, используя многократных ведущих.

SELECT

раньше находил самое близкое положение двоичной регистрации к самой высокой

прикладной эпохе на ведомом в мультиосновной установке (см.

главу 8.10

), используя эти две колонки, которые не внесены в индекс.

Это может привести к исполнительным проблемам, пытаясь свалиться, так как

запрос должен выполнить сканирование таблицы, особенно когда ведущий работал

с

--ndb-log-empty-epochs=ON.

Можно улучшить времена отказоустойчивости, добавляя индекс к этим колонкам,

как показано здесь:

ALTER TABLE mysql.ndb_binlog_index

ADD INDEX orig_lookup USING BTREE (orig_server_id, orig_epoch);

orig_server_id или

orig_epoch.next_position и

next_file.mysql.ndb_binlog_index.

ndb_apply_status

используется, чтобы вести учет операций, которые копировались от ведущего

ведомому. В отличие от случая с

ndb_binlog_index,

данные в этой таблице не определены ни для какого узла SQL в (ведомом)

кластере, и таким образом,

ndb_apply_status может использовать механизм

NDBCLUSTER:

CREATE TABLE `ndb_apply_status` (`server_id` INT(10) UNSIGNED NOT NULL,

`epoch` BIGINT(20) UNSIGNED NOT NULL,

`log_name`VARCHAR(255) CHARACTER SET latin1

COLLATE latin1_bin NOT NULL,

`start_pos` BIGINT(20) UNSIGNED NOT NULL,

`end_pos` BIGINT(20) UNSIGNED NOT NULL,

PRIMARY KEY (`server_id`) USING HASH)

ENGINE=NDBCLUSTER DEFAULT CHARSET=latin1;

ndb_apply_status

наполнена только на ведомых, что означает, что на ведущем эта таблица никогда

не содержит строк, таким образом нет никакой потребности допускать

DataMemory или

IndexMemory для

ndb_apply_status там.ndb_apply_status

или ведущий написал в двоичный журнал, может блокировать репликацию.

Для получения дополнительной информации о потенциальных проблемах, являющихся

результатом таких правил фильтрации, посмотрите

здесь.ndb_binlog_index и

ndb_apply_status составлены в БД

mysql потому,

что они не должны явно копироваться пользователем. Вмешательство пользователя

обычно не требуется, чтобы создать или поддержать любую из этих таблиц,

начиная с ndb_binlog_index и

ndb_apply_status. Это сохраняет основной процесс

mysqld

обновленным к изменениям, выполненным

NDB.

NDB

binlog injector thread

получает события непосредственно из механизма

NDB.

NDB

инжектор ответственен за захват всех событий данных в группе и гарантирует,

чтобы все события, которые изменили, вставили или удалили данные,

зарегистрированы в таблице ndb_binlog_index.

Ведомый поток I/O передает события от двоичной регистрации ведущего

до регистрации ведомого.mysql.ndb_binlog_index

непосредственно на ведущем. Это может быть также быть достигнуто, используя

SHOW BINLOG EVENTS

о ведущем или о ведомом сервере репликации MySQL. См.

SHOW BINLOG EVENTS Statement.SHOW ENGINE NDB STATUS.NDB,

запросы должны ждать окончания запроса

ALTER TABLE на связи с

клиентом MySQL, который сделал запрос, прежде чем попытаться использовать

обновленное определение таблицы.ndb_apply_status нет,

на ведомом,

ndb_restore

ее пересоздаст.mysql.ndb_replication.

В настоящее время эта таблица должна быть составлена вручную.

Для получения информации о том, как сделать это, посмотрите

главу 8.11.

8.5. Подготовка NDB Cluster для репликации

mysqlM> GRANT REPLICATION SLAVE ON *.*

TO 'slave_user'@'slave_host'

IDENTIFIED BY 'slave_password';

slave_user это имя пользователя,

slave_host это имя хоста или

IP-адрес ведомого репликации и

slave_password это пароль.myslave для входа в систему от хоста

rep-slave с паролем

53cr37, используйте такой запрос

GRANT:

mysqlM> GRANT REPLICATION SLAVE

ON *.* TO 'myslave'@'rep-slave'

IDENTIFIED BY '53cr37';

CHANGE MASTER TO:

mysqlS> CHANGE MASTER TO MASTER_HOST='master_host',

MASTER_PORT=master_port, MASTER_USER='slave_user',

MASTER_PASSWORD='slave_password';

master_host

это имя хоста или IP-адрес ведущего репликации,

master_port это порт для ведомого,

чтобы использовать для соединения с ведущим,

slave_user

это имя пользователя, настроенное для ведомого на ведущем, и

slave_password

пароль для этой учетной записи пользователя.rep-master, с использованием ведомого

репликации, созданного на предыдущем шаге, используйте следующий запрос:

mysqlS> CHANGE MASTER TO MASTER_HOST='rep-master',

MASTER_PORT=3306, MASTER_USER='myslave',

MASTER_PASSWORD='53cr37';

--ndb-connectstring в файл

my.cnf ведомого до старта процесса репликации.

Посмотрите

главу 8.9.my.cnf для ведомых репликации посмотрите

Replication and Binary Logging Options and Variables

.

ndb-connectstring=management_host[:port]

shellM> mysqldump --master-data=1

dump_file это

название файла, который был произведен, используя

mysqldump

на ведущем, а db_name это

название базы данных, которая будет копироваться:

shellS> mysql -u root -p db_name < dump_file

--skip-slave-start

или иначе включить skip-slave-start в его файл

my.cnf, чтобы помешать ему пытаться соединиться

с ведущим, чтобы начать копировать до загрузки всех данных.

Как только загрузка данных закончена, выполните дополнительные шаги,

обрисованные в общих чертах в следующих двух секциях.my.cnf главного сервера

или в командной строке, начиная основной процесс

mysqld. См.

главу 8.6.

8.6. Старт NDB Cluster Replication (единственный канал репликации)

shellM> mysqld --ndbcluster --server-id=id --log-bin &

id это

уникальный идентификатор этого сервера (см.

главу 8.2).

Это начинает процесс mysqld

с включенным двоичным журналом, чтобы использовать

надлежащий формат регистрации.--binlog-format=MIXED,

в этом случае построчная репликация используется автоматически, копируя между

группами. Журнал в режиме STATEMENT

не поддерживается для NDB Cluster Replication (см.

главу 8.2

).

shellS> mysqld --ndbcluster --server-id=id &

id это уникальный

идентификатор сервера ведомого. Нет необходимости включать

журналирование ведомого репликации.--skip-slave-start

с этой командой или иначе необходимо включать

skip-slave-start в файле

my.cnf ведомого, если вы не хотите, чтобы

репликация немедленно началась. С использованием этого выбора начало

репликации задержано до соответствующей команды

appropriate START SLAVE, как

объяснено в шаге 4 ниже.

mysqlS> CHANGE MASTER TO MASTER_LOG_FILE='', MASTER_LOG_POS=4;

MASTER_LOG_FILE и

MASTER_LOG_POS в таких случаях.

mysql

S> START SLAVE;

slave_allow_batching на ведомом

mysqld.

Обычно обновления применяются, как только они получены.

Однако, использование группирования обновлений собирает их в пакеты

по 32 КБ, что может привести к более высокой пропускной способности и

меньшему использованию CPU, особенно там, где отдельные

обновления относительно маленькие.

SET GLOBAL slave_allow_batching = 1;

SET GLOBAL slave_allow_batching = ON;

SET GLOBAL slave_allow_batching = 0;

SET GLOBAL slave_allow_batching = OFF;

SHOW VARIABLES:

mysql> SHOW VARIABLES LIKE 'slave%';

+---------------------------+-------+

| Variable_name | Value |

+---------------------------+-------+

| slave_allow_batching | ON |

| slave_compressed_protocol | OFF |

| slave_load_tmpdir | /tmp |

| slave_net_timeout | 3600 |

| slave_skip_errors | OFF |

| slave_transaction_retries | 10 |

+---------------------------+-------+

6 rows in set (0.00 sec)

8.7. Используя два канала репликации для NDB Cluster Replication

Server ID Описание 1

Ведущий основной канал

(M) 2

Ведущий вторичный канал

(M') 3

Ведомый основной канал

(S) 4

Ведомый вторичный канал

(S') START SLAVE

на каждом из ведомых. Команды и порядок, в котором они должны быть

выпущены, показывают здесь:

shellM> mysqld --ndbcluster --server-id=1 --log-bin &

shellM'> mysqld --ndbcluster --server-id=2 --log-bin &

shellS> mysqld --ndbcluster --server-id=3 --skip-slave-start &

shellS'> mysqld --ndbcluster --server-id=4 --skip-slave-start &

START SLAVE

на основном ведомом как показано здесь:

mysql

S> START SLAVE;

8.8. Осуществление отказоустойчивости с NDB Cluster Replication

ndb_apply_status на ведомом, которая

может быть найдена, используя следующий запрос:

mysqlS'> SELECT @latest:=MAX(epoch) FROM mysql.ndb_apply_status;

ndb_log_apply_status=1, эпохи NDB Cluster

написаны в двоичный журнал ведомого. Это означает, что таблица

ndb_apply_status

содержит информацию для ведомого на этом хосте, а также для любого другого

хоста, который действует как ведомый ведущего на этом хосте.IGNORE_SERVER_IDS запроса

CHANGE MASTER TO,

которым раньше настраивали этого ведомого. Причина исключения таких эпох

в том, что строки в таблице

mysql.ndb_apply_status, у сервера которых ID

совпадает с IGNORE_SERVER_IDS в списке,

используемом с CHANGE MASTER TO, которым раньше готовили ведущего этого

ведомого, также считается от локальных серверов, в дополнение к тем, которые

имеют собственный ID сервера ведомого. Можно восстановить этот список как

Replicate_Ignore_Server_Ids из вывода

SHOW SLAVE STATUS.

Мы предполагаем, что вы получили этот список и заменяете им

ignore_server_ids

в запросе, показанном здесь, который как предыдущая версия запроса, выбирает

самую большую эпоху в переменную

@latest:

mysqlS'> SELECT @latest:=MAX(epoch) FROM mysql.ndb_apply_status

WHERE server_id NOT IN (ignore_server_ids);

server_id IN

в части

server_id_listWHERE предыдущего запроса.ndb_binlog_index на основном кластере.ndb_binlog_index ведущего:

mysqlM'> SELECT @file:=SUBSTRING_INDEX(next_file, '/', -1),

@pos:=next_position FROM mysql.ndb_binlog_index

WHERE epoch >= @latest ORDER BY epoch ASC LIMIT 1;

@latest, чтобы

представлять значение, полученное в шаге 1. Конечно, невозможно для

одного mysqld

обратиться к переменным пользователя на другом экземпляре сервера

непосредственно. Эти значения должны быть вставлены

во второй запрос вручную или в коде приложения.--slave-skip-errors=ddl_exist_errors

перед выполнением

START SLAVE.

Иначе репликация может остановиться с ошибками дублирования DDL.

mysqlS'> CHANGE MASTER TO MASTER_LOG_FILE='@file', MASTER_LOG_POS=@pos;

@file и @pos),

чтобы представлять значения, полученные в шаге 2 и примененные в шаге 3.

На практике эти значения должны быть вставлены вручную или используя код

приложения, которое может получить доступ к обоим из включенных серверов.@file это значение последовательности, такое

как '/var/log/mysql/replication-master-bin.00001'

, оно должно быть указано, когда используется в SQL или коде

приложения. Однако, значение, представленное

@pos,

НЕ должно быть цитировано.

Хотя MySQL обычно пытается преобразовать последовательности в числа,

этот случай исключение.

mysql

S'> START SLAVE;

M на

S' или от

M' на

S.

Однако, это еще не было проверено.

8.9. Резервирование NDB Cluster с NDB Cluster Replication

[mysql_cluster] файла

my.cnf file, где

management_host это

IP-адрес или имя хоста сервера управления

NDB

для основного кластера, а port

это номер порта сервера управления:

ndb-connectstring=management_host[:port]

shellM> ndb_mgm -e "START BACKUP"

my.cnf не определяет, где найти хост

управления, можно начать процесс резервного копирования, передав эту

информацию клиенту управления

NDB как часть команды

START BACKUP.

Это может быть сделано как показано здесь, где

management_host и

port

имя хоста и номер порта сервера управления:

shellM> ndb_mgm management_host:port -e "START BACKUP"

shellM> ndb_mgm rep-master:1186 -e "START BACKUP"

/var/BACKUPS/BACKUP-1.--skip-slave-start,

чтобы предотвратить преждевременный запуск процесса репликации.CREATE DATABASE (или

CREATE SCHEMA),

соответствующий каждой базе данных, которая будет копироваться, должен быть

выполнен на каждом узле SQL в ведомой группе.

mysql

S> RESET SLAVE;

-m, чтобы

восстановить метаданные группы:

shellS> ndb_restore -c slave_host:port -n node-id \

-b backup-id -m -r dir

dir это

путь к каталогу, куда резервные файлы были помещены в ведомом репликации.

Для

ndb_restore

соответствующих остающимся резервным файлам, опция

-m

НЕ используется./var/BACKUPS/BACKUP-1,

надлежащая последовательность команд, которые будут выполнены на ведомом,

могла бы быть похожей на это:

shellS> ndb_restore -c rep-slave:1186 -n 2 -b 1 -m \

-r ./var/BACKUPS/BACKUP-1

shellS> ndb_restore -c rep-slave:1186 -n 3 -b 1 \

-r ./var/BACKUPS/BACKUP-1

shellS> ndb_restore -c rep-slave:1186 -n 4 -b 1 \

-r ./var/BACKUPS/BACKUP-1

shellS> ndb_restore -c rep-slave:1186 -n 5 -b 1 -e \

-r ./var/BACKUPS/BACKUP-1

-e (или

--restore-epoch) в заключительном вызове

ndb_restore

в этом примере требуется, чтобы эпоха была написана ведомому

mysql.ndb_apply_status.

Без этой информации ведомый не будет в состоянии синхронизироваться

правильно с ведущим (см.

главу 6.24

).ndb_apply_status на ведомом (как обсуждено в

главе 8.8):

mysqlS> SELECT @latest:=MAX(epoch) FROM mysql.ndb_apply_status;

@latest как

значение эпохи в предыдущем шаге, можно получить правильную стартовую позицию

@pos в правильном файле двоичного журнала

@file из таблицы

mysql.ndb_binlog_index ведущего,

используя запрос, показанный здесь:

mysqlM> SELECT @file:=SUBSTRING_INDEX(File, '/', -1), @pos:=Position

FROM mysql.ndb_binlog_index WHERE epoch >= @latest

ORDER BY epoch ASC LIMIT 1;

SHOW MASTER STATUS

на ведущем и используя значения в столбце

Position

для файла, у имени которого есть суффикс с самым большим значением

для всех файлов, показанных в столбце File.

Однако, в этом случае необходимо определить это и поставлять его в следующем

шаге вручную или разбирая вывод скриптом.CHANGE MASTER TO

в клиенте mysql на ведомом:

mysqlS> CHANGE MASTER TO MASTER_LOG_FILE='@file', MASTER_LOG_POS=@pos;

mysql

S> START SLAVE;

8.9.1. NDB Cluster Replication: автоматизация синхронизации ведомого

репликации с основной двоичной регистрацией

reset-slave.pl

служит примером того, как можно сделать это.

#!/user/bin/perl -w

#file: reset-slave.pl

#Copyright б╘2005 MySQL AB

#This program is free software; you can redistribute it and/or modify

#it under the terms of the GNU General Public License as published by

#the Free Software Foundation; either version 2 of the License, or

#(at your option) any later version.

#This program is distributed in the hope that it will be useful,

#but WITHOUT ANY WARRANTY; without even the implied warranty of

#MERCHANTABILITY or FITNESS FOR A PARTICULAR PURPOSE.See the