|

|

|

|||

| WebMoney: WMZ Z294115950220 WMR R409981405661 WME E134003968233 |

Visa 4274 3200 2453 6495 |

|

|

|

|||

| WebMoney: WMZ Z294115950220 WMR R409981405661 WME E134003968233 |

Visa 4274 3200 2453 6495 |

NDB Cluster

технология, которая позволяет кластеризовать базы данных в памяти.

Эта архитектура позволяет системе работать с очень недорогими аппаратными

средствами, и с минимумом определенных требований для аппаратных средств

или программного обеспечения. NDB Cluster разработан, чтобы не иметь единственную точку сбоя. У каждого

компонента, как ожидают, будут своя собственная память и диск, использование

механизмов совместно используемой памяти, таких как сетевые ресурсы, сетевые

файловые системы и SAN не рекомендуется или поддерживается. NDB Cluster объединяет стандартный сервер MySQL с механизмом

кластерной системы хранения в памяти

NDB Cluster состоит из ряда компьютеров, известных как

хосты, каждый управляет одним или более

процессами. Эти процессы, известные как

узлы,

могут включать серверы MySQL (для доступа к данным NDB), узлы данных (для

хранения данных), один или несколько серверов управления и возможно другие

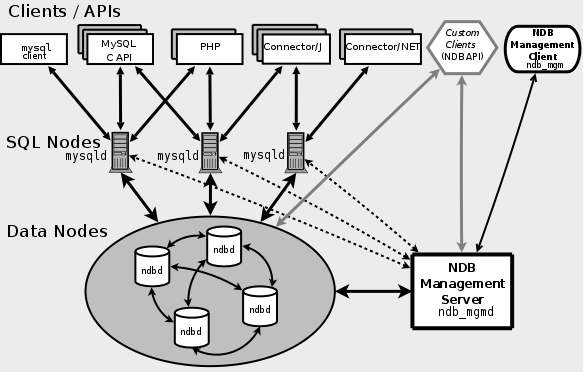

специализированные программы доступа к данным. Отношения этих компонентов в

NDB Cluster показывают здесь: Рис. 3.1. Компоненты NDB Cluster Все эти программы сотрудничают, чтобы сформировать NDB Cluster (см.

главу 6. Когда данные хранятся в механизме

Хотя в NDB Cluster узел SQL использует

mysqld, он отличается по многим

критическим отношениям от

mysqld в MySQL 5.7, эти две

версии mysqld

не взаимозаменяемые. Кроме того, сервер MySQL, который не связан с NDB Cluster, не может

использовать механизм Данные в узлах данных для NDB Cluster

могут быть отражены, группа может обращаться с неудачами отдельных узлов

данных без другого воздействия, небольшое количество транзакций прерывается

из-за потери операционного состояния. Поскольку транзакционные приложения,

как ожидают, будут обращаться со сбоем транзакции, это не должно

быть источником проблем. Отдельные узлы могут быть остановлены и перезапущены и могут тогда

воссоединиться с системой. Катящийся перезапуск (в котором все узлы

перезапущены в свою очередь) используется в создании изменений конфигурации и

обновлений программного обеспечения (см.

раздел 7.5).

Катящиеся перезапуски также используются в качестве части процесса добавления

новых узлов данных онлайн (см.

раздел 7.15).

Для получения дополнительной информации об узлах данных, как они организованы

в NDB Cluster, и как они обращаются и хранят данные NDB Cluster см.

раздел 3.2. Поддержка и восстановление баз данных NDB Cluster могут быть сделаны,

используя функциональность Узлы NDB Cluster могут использовать различные транспортные механизмы для

коммуникаций междоузлия, TCP/IP по стандарту, 100 Мбит/с или более быстрые

аппаратные средства Ethernet, используется в большей

части реального развертывания. Механизм Кластерная часть NDB Cluster

формируется независимо от серверов MySQL. В NDB Cluster каждая

часть считается узлом. Во многих контекстах термин узел

используется, чтобы указать на компьютер, но обсуждая NDB Cluster

это означает процесс.

Возможно управлять многократными узлами на одиночном компьютере,

для компьютера, на котором управляют одним или большим количеством узлов

кластера, мы используем термин

хост кластера. Есть три типа узлов, в минимальной конфигурации NDB будет по крайней мере

три узла, один из каждого из этих типов: Узел управления:

роль этого типа узла должна управлять другими узлами в NDB Cluster,

выполняя такие функции как обеспечение данных конфигурации, старт и остановка

узлов и управление резервными копиями. Поскольку этот тип узла управляет

конфигурацией других узлов, узел этого типа должен быть начат сначала перед

любым другим узлом. Узел MGM начат командой

ndb_mgmd. Узел данных:

Этот тип узла хранит данные. Есть столько же узлов данных, сколько есть

точных копий, помноженных на количество фрагментов (см.

раздел 3.2).

Например, с двумя точными копиями, каждая с двумя фрагментами, вам нужны

четыре узла данных. Одна точная копия достаточна для хранения данных, но не

обеспечивает избыточности, поэтому, рекомендуется иметь 2 (или больше) точных

копии, чтобы обеспечить избыточность и таким образом высокую доступность.

Узел данных начат командой

ndbd (см.

раздел 6.1) или

ndbmtd (см.

раздел 6.3). Таблицы NDB Cluster обычно хранятся полностью в памяти, а не на диске.

Однако некоторые данные NDB Cluster могут храниться на диске, см.

раздел 7.13. Узел SQL:

Это узел, который получает доступ к данным. В случае NDB Cluster

узел SQL традиционный сервер MySQL, который использует механизм

Узел SQL на самом деле просто специализированный тип

узла API,

который определяет любое применение, которому доступны данные NDB Cluster.

Другой пример узла API это утилита

ndb_restore, которая

используется, чтобы восстановить резервную копию.

Возможно написать такие запросы, используя API NDB. Для основной информации

о API NDB посмотрите

здесь. Нереалистично ожидать использовать установку с тремя узлами в

производственной среде. Такая конфигурация не обеспечивает избыточности,

чтобы извлечь выгоду из высоконадежных особенностей NDB Cluster, необходимо

использовать многократные узлы SQL и данных. Использование многократных узлов

управления также настоятельно рекомендовано. Для краткого введения в отношения между узлами, группами узлов, точными

копиями и разделами в NDB Cluster см.

раздел 3.2. Конфигурация группы вовлекает формирование каждого отдельного узла и

соединений между ними. NDB Cluster в настоящее время разрабатывается с

намерением, что узлы данных гомогенные с точки зрения питания процессора,

пространства памяти и пропускной способности. Кроме того, чтобы обеспечить

единственный пункт конфигурации, все данные конфигурации для группы в целом

расположены в одном конфигурационном файле. Сервер управления управляет файлом кластерной конфигурации и

журналом кластера. Каждый узел в группе получает данные конфигурации от

сервера управления, это требует способ определить, где искать сервер

управления. Когда интересные события имеют место в узлах данных, узлы

передают информацию об этих событиях серверу управления, который

пишет информацию в журнал. Кроме того, может быть любое количество клиентских процессов.

Они включают типичных клиентов MySQL, программы

Типичные клиенты MySQL. NDB Cluster может использоваться с

существующими приложениями MySQL, написанными на PHP, Perl, C, C++, Java,

Python, Ruby и т.д. Такие клиентские приложения посылают SQL-операторы и

получают ответы от серверов MySQL, действующих как узлы SQL в NDB Cluster

почти таким же способом, которым они взаимодействуют с

автономными серверами MySQL. Клиенты MySQL, использующие NDB Cluster в качестве источника данных, могут

быть изменены, чтобы использовать в своих интересах способность соединиться с

многими серверами MySQL, чтобы достигнуть выравнивания нагрузки и

отказоустойчивости. Например, клиенты Java через Connector/J 5.0.6 и позже

могут использовать URL

Программы клиента NDB. Программы клиента могут быть написаны

для доступа к NDB Cluster непосредственно из механизма хранения

NDB Cluster также поддерживает приложения, написанные на JavaScript с

Node.js. MySQL Connector для JavaScript включает адаптеры для прямого доступа

к Memcache API для NDB Cluster работает как загружаемый механизм хранения

ndbmemcache для memcached версии 1.6 и позже,

может использоваться, чтобы обеспечить постоянному хранилищу данных NDB

Cluster доступ к использованию протокола кэш-памяти. Стандартное кэширование memcached

включено в NDB Cluster 7.5. Ккаждый сервер

memcached

имеет прямой доступ к данным в NDB Cluster,

но также в состоянии обратиться к данным кэша в местном масштабе. См. ndbmemcache Memcache API for NDB Cluster. Клиенты управления. Эти клиенты соединяются с сервером управления и

обеспечивают команды для старта и остановки узлов, старта и остановки

отслеживания сообщения (только отладочные версии), показ версий узла и

статуса, старта и остановки резервных копий и так далее. Пример этого типа

программы:

ndb_mgm (см.

раздел 6.5).

Такие запросы могут быть написаны, используя

MGM API, C-подобный API

который общается непосредственно с одним или более серверами управления

NDB Cluster. См. The MGM API. Oracle также делает доступным MySQL Cluster Manager,

который обеспечивает современный интерфейс командной строки, упрощающий

многие сложные задачи управления NDB Cluster, например, перезапуск NDB

Cluster с большим количеством узлов. Клиент MySQL Cluster Manager

также поддерживает команды для того, чтобы получить и установить значения

большинства параметров конфигурации узла, а также опции и переменные сервера

mysqld, связанные с

NDB Cluster. См.

MySQL Cluster Manager 1.4.8 User Manual. Журналы событий. NDB Cluster регистрирует события по категориям

(запуск, закрытие, ошибки, контрольные точки и так далее), приоритету и

серьезности. Полный список всех заслуживающих публикации событий может быть

найден в

разделе 7.6. Журналы событий имеют эти два типа: Cluster log:

Ведет учет всех желаемых заслуживающих публикации событий

для группы в целом. Node log:

отдельная регистрация, которая также сохранена для

каждого отдельного узла. При нормальных обстоятельствах необходимо и достаточно держать и

исследовать только регистрацию группы. Регистрации узла нужны

только в целях разработки приложений и отладки. Контрольная точка. Вообще говоря, когда данные сохраняются на диск,

сказано, что контрольная точка

была достигнута. Более определенно для NDB Cluster,

контрольная точка это момент времени, где все переданные транзакции сохранены

на диске. Относительно Local Checkpoint (LCP):

Это контрольная точка, которая является определенной для единственного узла,

однако, LCP происходят для всех узлов в группе более или менее одновременно.

LCP обычно происходит каждые несколько минут, точный интервал варьируется и

зависит от объема данных, сохраненного узлом,

уровня деятельности группы и других факторов. До NDB 7.6.4 LCP включала сохранение на диск всех данных узла. NDB 7.6.4

вводит поддержку частичной LCP, что может значительно улучшить время

восстановления при некоторых условиях. Посмотрите

раздел 3.4.2,

а также описания параметров конфигурации

Global Checkpoint (GCP):

GCP происходит каждые несколько секунд, когда транзакции для всех узлов

синхронизированы, а журнал отката сбрасывается на диск. Для получения дополнительной информации о файлах и каталогах, созданных

местными контрольными точками и глобальными контрольными точками, см.

NDB Cluster Data Node File System Directory Files. Эта секция обсуждает способ, которым NDB Cluster

делит и дублирует данные для хранения. Много понятий, важных в понимании этой темы, обсуждены в

следующих нескольких параграфах. Узел данных.

Процесс

ndbd или

ndbmtd, который хранит одну или более

точных копий то есть, копии

разделов,

назначенных на группу узлов, членом которой является узел. Каждый узел данных должен быть расположен на отдельном компьютере. В то

время как также возможно запустить многократные процессы узла данных на

одном компьютере, такая конфигурация обычно не рекомендуется. Терминам узел и

узел данных

свойственно использоваться попеременно, относясь к процессам

ndbd или

ndbmtd, где упомянуто, узлам управления

(процесс

ndb_mgmd) и

узлам SQL (процесс mysqld). Группа узла.

Группа узла состоит из одного или более узлов и хранит разделение или наборы

точных копий. Количество групп узла в NDB Cluster не конфигурируемо непосредственно,

это функция количества узлов данных и количества точных копий

(параметр конфигурации

Таким образом у NDB Cluster с 4 узлами данных есть 4 группы узла, если

У всех групп узлов в NDB Cluster

должно быть то же самое количество узлов данных. Можно добавить новые группы узлов

(и таким образом новые узлы данных) онлайн к работающему NDB Cluster, см.

раздел 7.15. Разделы.

Это часть данных. Каждый узел ответственен за хранение по крайней мере одной

копии любого разделения, назначенного на него (то есть, по крайней мере

одной точной копии). Количество разделов, используемых по умолчанию NDB Cluster,

зависит от количества узлов данных и количества потоков

LDM, задействованных узлами: Используя узлы данных, работающие с

ndbmtd, число потоков LDM

управляется

NDB и определенное пользователями разделение. NDB Cluster

обычно разделяет таблицы

Только схемы Максимальное количество разделов, которое может быть определено явно

для любой таблицы См. раздел 6.3.

Для получения дополнительной информации о NDB Cluster

и определенного пользователями разделения посмотрите разделы

3.7 и

Partitioning Limitations Relating to Storage Engines. Точная копия.

Это копия разделения группы. Каждый узел в группе узлов хранит точную копию.

Также иногда известно как

точная копия разделения.

Количество точных копий равно количеству узлов на группу узлов. Точная копия принадлежит полностью единственному узлу, узел может (и

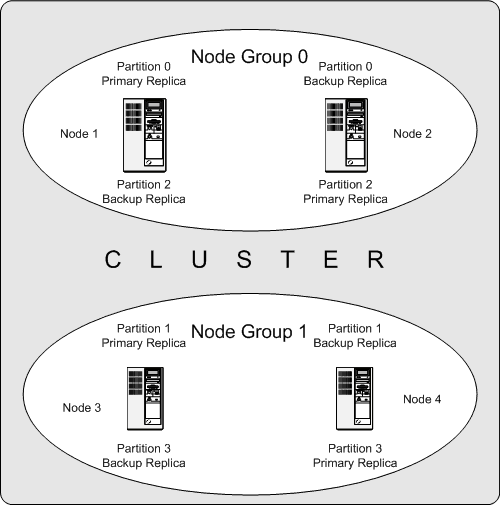

обычно так и делает) хранить несколько точных копий. Следующая диаграмма иллюстрирует NDB Cluster с четырьмя узлами данных,

работающими с

ndbd,

в двух группах из двух узлов каждая,

узлы 1 и 2 принадлежат группе узлов 0, а узлы 3 и 4 принадлежат группе 1. Только узлы данных показывают здесь, хотя работа NDB Cluster

требует процесса

ndb_mgmd

для управления и по крайней мере одного узла SQL для доступа к данным,

они были опущены на рисунке для ясности. Рис. 3.2. NDB Cluster с двумя группами узлов Данные, хранившие группой, разделены на четыре раздела,

пронумерованных 0, 1, 2 и 3. Каждый раздел сохранен в многочисленных копиях

в той же самой группе узлов. Разделение сохранено в дополнительных группах

узлов следующим образом: Раздел 0 сохранен в группе 0,

основная точная копия (основная копия)

сохранена на узле 1, резервная точная копия

(резервная копия раздела) сохранена на узле 2. Раздел 1 сохранен в другой группе узлов (группа 1),

основная точная копия этого разделения находится на узле 3,

его резервная точная копия находится на узле 4. Раздел 2 сохранен в группе узлов 0.

Однако размещение его двух точных копий полностью иное: основная точная копия

сохранена на узле 2, резервная копия на узле 1. Раздел 3 сохранен в группе узлов 1,

размещение его двух точных копий полностью отлично от раздела 1.

Таким образом, его основная точная копия расположена на узле 4 с

резервной копией на узле 3. Вот что это означает относительно длительной работы NDB Cluster:

пока у каждой группы узлов есть по крайней мере один рабочий узел,

группа имеет полную копию всех данных и остается жизнеспособной.

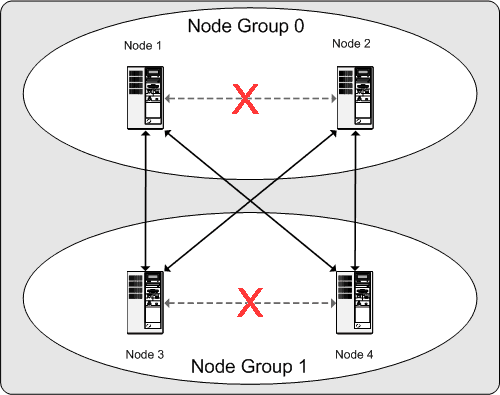

Это иллюстрировано на следующей диаграмме. Рис. 3.3. Узлы, необходимые для 2x2 группы NDB Cluster В этом примере кластер состоит из двух групп узлов, каждая

из двух узлов данных. Каждый узел данных управляет

ndbd.

Любая комбинация из по крайней мере одного узла группы 0 и по крайней мере

одного узла группы 1 достаточна, чтобы поддержать кластер.

Однако, если оба узла от единственной группы узлов

терпят неудачу, комбинация, состоящая из

двух узлов в другой группе узла, недостаточна.

В этой ситуации кластер потерял все разделение и больше не может обеспечивать

доступ к полному набору всех данных. В NDB 7.5.4 и позже максимальное количество групп узлов для единственного

экземпляра NDB Cluster = 48 (Bug#80845, Bug #22996305). Одно из преимуществ NDB Cluster: им

можно управлять на потребительском оборудовании и не имеется никаких

необычных требований в этом отношении, кроме больших объемов RAM, вследствие

того, что все живое хранение данных сделано в памяти.

Возможно уменьшить это требование, используя таблицы Disk Data, см

раздел 7.13.

Естественно, многократные и более быстрые CPU могут увеличить

производительность. Требования к памяти для других процессов NDB

Cluster относительно небольшие. Требования к программному обеспечению для NDB Cluster

также скромны. Хостовые операционные системы не требуют, чтобы любые

необычные модули, сервисы, запросы или конфигурация поддерживали NDB Cluster.

Для поддержанных операционных систем стандартная установка должна быть

достаточной. Требования к программному обеспечению MySQL просты: все, что

необходимо, является производственным выпуском NDB Cluster.

Не строго необходимо собрать MySQL самостоятельно просто, чтобы быть

в состоянии использовать NDB Cluster.

Мы предполагаем, что вы используете двоичные модули, соответствующие вашей

платформе, доступные из программного обеспечения NDB Cluster со страницы

https://dev.mysql.com/downloads/cluster/. Для связи между узлами NDB Cluster поддерживает TCP/IP

поддерживает TCP/IP, общающийся через Интернет в любой стандартной топологии,

и минимум, ожидаемый для каждого хоста,

является стандартной картой Ethernet на 100 Мбит/с плюс роутер, свитч или

хаб, чтобы обеспечить сетевое соединение для группы в целом.

Мы сильно рекомендуем, чтобы NDB Cluster работал в

собственной подсети, которая не разделена с машинами, не являющимися

частью группы по следующим причинам: Безопасность. Связи между узлами не зашифрованы.

Единственное средство защиты передач состоит в том, чтобы управлять вашим NDB

Cluster в защищенной сети. Если вы намереваетесь использовать NDB

Cluster для Web, кластер должен определенно находиться позади вашего

брандмауэра, а не в De-Militarized Zone

(DMZ) или в другом месте. См.

раздел 7.12.1. Эффективность.

NDB Cluster в частной или защищенной сети позволяет

сделать исключительное использование пропускной способности между

хостами группы. Использование отдельного коммутатора для NDB Cluster

не только помогает защититься от несанкционированного доступа к данным,

это также гарантирует, что узлы ограждены от вмешательства, вызванного

передачами между другими компьютерами в сети. Для расширенной надежности

можно использовать двойные коммутаторы и двойные карты, чтобы удалить

сеть как единственный пункт сбоя,

много драйверов устройств поддерживают отказоустойчивость для

таких линий связи.

Сетевая коммуникация и время ожидания. NDB Cluster требует связи между

узлами данных и узлами API (включая узлы SQL), а также между узлами данных и

другими узлами данных, чтобы выполнить запросы и обновления. Коммуникационное

время ожидания между этими процессами может непосредственно затронуть

наблюдаемую работу и время ожидания пользовательских запросов. Кроме того,

чтобы поддержать последовательность и обслуживание несмотря на тихую неудачу

узлов, NDB Cluster использует механизмы тайм-аута, которые рассматривают

расширенную потерю сообщения узла как сбой узла. Это может привести к

уменьшенной избыточности. Вспомните, что, чтобы поддержать непротиворечивость

данных, NDB Cluster закрывается, когда последний узел в группе узлов

терпит неудачу. Таким образом, чтобы избежать увеличения риска

принудительного закрытия, перерывов в связи между узлами нужно избегать

по мере возможности. Неудача узла данных или API приводит к аварийному прекращению работы всех

нейтральных транзакций, включающих неудавшийся узел.

Восстановление узла данных требует синхронизации данных неудавшегося узла из

выживающего узла данных, и восстановление находящихся на диске журналов

контрольной точки, прежде чем узел данных возвратится к работе.

Это восстановление может занять время, во время которого кластер

работает с уменьшенной избыточностью. Синхронизация полагается на своевременную генерацию

сигналов всеми узлами. Это может не быть возможно, если узел перегружен,

имеет недостаточной мощный CPU из-за разделения с другими программами или

испытывает задержки из-за обмена. Если генерация достаточно задержана, другие

узлы рассматривают узел, который не спешит отвечать, как сбойный. Эта обработка медленного узла может не быть желательной при некоторых

обстоятельствах, в зависимости от воздействия замедленного действия узла на

кластер. Устанавливая значения тайм-аута

Где коммуникационные времена ожидания между узлами данных, как ожидают,

будут выше, чем ожидалось бы в окружающей среде LAN (примерно 100 мкс),

параметры перерыва должны быть увеличены, чтобы гарантировать, что любые

позволенные периоды ожидания укладываются в настройки.

Увеличение перерывов таким образом имеет соответствующий эффект на время

худшего случая, чтобы обнаружить сбой. Окружающая среда LAN может, как правило, формироваться со стабильным

низким временем ожидания и таким образом,

может предоставить избыточность и быструю отказоустойчивость.

Отдельные неудачи связи могут быть восстановлены с минимальным временем

ожидания на уровне TCP (где NDB Cluster нормально работает).

Окружающая среда WAN может предложить диапазон времен ожидания, а также

избыточность с более медленными временами отказоустойчивости.

Отдельные неудачи связи могут потребовать, чтобы изменения маршрута

размножились, прежде чем непрерывная возможность соединения будет

восстановлена. На уровне TCP это может проявиться как большие времена

ожидания на отдельных каналах. Худший случай времени ожидания TCP в этих

сценариях связан со временем худшего случая для слоя IP,

чтобы изменить маршрут. Следующие разделы описывают изменения в

NDB Cluster в MySQL NDB Cluster 7.6 5.7.29-ndb-7.6.13 и в NDB Cluster 7.5

5.7.29-ndb-7.5.17 по сравнению с более ранним рядом выпусков. NDB Cluster 8.0

доступен как General Availability (GA), начиная с NDB 8.0.19, см.

What is New in NDB Cluster. NDB Cluster 7.6 и 7.5

являются предыдущими GA releases, они все еще поддержанные в производстве,

для получения информации о NDB Cluster 7.6 см.

раздел 3.4.2.

Для подобной информации о NDB Cluster 7.5 см.

раздел 3.4.1.

NDB Cluster 7.4 и 7.3 являются предыдущими GA releases, они все еще

поддержанные в производстве, хотя мы рекомендуем, чтобы новое развертывание

для производства использовало NDB Cluster 8.0, см.

MySQL NDB Cluster 7.3 and NDB Cluster 7.4. NDB Cluster 7.2

является прошлой серией GA release, которая больше не поддерживается для

нового развертывания, пользователи NDB 7.2 должны модернизировать систему до

более поздней версии. Для получения дополнительной информации о NDB Cluster

7.2 см. MySQL NDB Cluster 7.2. Существенные изменения и новые особенности в NDB Cluster 7.5, которые,

вероятно, будут представлять интерес, показывают в следующем списке: Улучшения ndbinfo. Много изменений внесены в базу данных

Таблица

Строка в таблице

Используя эти отношения, можно написать соединение на этих двух таблицах,

чтобы получить умолчание, максимум, минимум и текущее значение для одного или

более параметров кластерной конфигурации NDB по имени. SQL-оператор в

качестве примера, используя такое соединение показывают здесь: См. разделы

7.10.8 и

раздел 7.10.9. Кроме того, база данных Несколько новых таблиц в

См. описания отдельных таблиц для

получения дополнительной информации. Строка по умолчанию и изменения формата столбца.

Начиная с NDB 7.5.1, значения по умолчанию для обоих опций

Формат строки и формат столбца, используемый существующими столбцами

таблицы, не затронуты этим изменением. Новые колонки, добавленные к таким

таблицам, используют новые умолчания для них (возможно отвергнуть

Копирование ndb_binlog_index больше не связан с MyISAM.

С NDB 7.5.2 таблица Выгода этого изменения: оно позволяет зависеть от транзакционного

поведения и без блокировок читает таблицы, что может помочь облегчить

проблемы параллелизма во время операций по чистке и ротации

регистрации, а также улучшить доступность этой таблицы. Новое в ALTER TABLE. NDB Cluster раньше поддерживал

альтернативный синтаксис для онлайн

Другое изменение, затрагивающее использование этого запроса,

в том, что Устарел параметр ExecuteOnComputer.

Параметр Оптимизация records-per-key.

Обработчик NDB теперь использует интерфейс records-per-key

для статистики индекса, осуществленной для оптимизатора в MySQL

5.7.5. Некоторые преимущества от этого изменения включают: Оптимизатор теперь выбирает лучшие планы выполнения во многих

случаях, где менее оптимальный индекс соединения или порядок

соединения таблицы были бы ранее выбраны. Оценки строки, показанные

Оценки количества элементов, показанные

Пул связей узлов.

NDB 7.5.0 добавляет опцию mysqld

Можно установить размер пула связи, используя опцию

Удалено create_old_temporals. Системная переменная

Команда PROMPT в клиенте ndb_mgm. NDB Cluster 7.5

добавляет новую команду для урегулирования приглашения командной строки

клиента. Следующий пример иллюстрирует использование команды

См.

раздел 7.2. Увеличенное хранение колонки FIXED на фрагмент.

NDB Cluster 7.5 и позже поддерживает максимум 128 TB на фрагмент данных в

столбце Убраны устаревшие параметры.

Следующие параметры конфигурации узла данных NDB Cluster

устарели в предыдущих выпусках NDB Cluster и удалены в NDB 7.5.0: Архаичный и неиспользуемый (поэтому также ранее недокументированный)

параметр конфигурации компьютера Эти параметры не поддерживаются в NDB 7.5. Попытка использовать любой из

этих параметров в файле кластерной конфигурации NDB

теперь приводит к ошибке. Улучшения сканирования DBTC.

Просмотры были улучшены, сократив количество сигналов, используемых для связи

между ядерными блоками Также, поскольку результат этого времени отклика должен быть значительно

улучшен, это может помочь предотвратить проблемы с перегрузкой главных

потоков. Кроме того, просмотры, сделанные в ядерном блоке

Поддержка столбцов JSON.

NDB 7.5.2 и позже понимает тип столбцов

Чтение от любой точной копии,

определите количество hashmap фрагментов раздела.

Ранее все чтения были направлены к основной точной копии, за исключением

простого чтения. Простым является чтение, которое захватывает

строку, читая ее. Начиная с NDB 7.5.2, возможно позволить чтение от любой

точной копии. Это отключено по умолчанию, но может быть позволено для данного

узла SQL, используя системную переменную

Ранее было возможно определить таблицы только с одним типом отображения

разделения с одним основным разделом на каждом LDM в каждом узле, но в

NDB 7.5.2 становится возможно быть более гибким в назначении разделения,

устанавливая баланс разделения (тип количества фрагментов).

Возможные схемы баланса: один на узел, один на группу узлов, один на LDM на

узел и один на LDM на группу узлов. Этим урегулированием можно управлять для отдельных таблиц посредством

опции В приложениях NDB API баланс разделения таблицы может также быть

получен и задан соответствующими методами, см.

Table::getPartitionBalance() и

Table::setPartitionBalance(), а также

Object::PartitionBalance. Как часть этой работы, NDB 7.5.2 также вводит системную переменную

Кроме того, при восстановлении схем таблицы,

ndb_restore

NDB 7.5.3 добавляет дальнейшее улучшение к

Улучшения ThreadConfig.

Много улучшений и дополнений осуществляются в NDB 7.5.2 для

Неисключительный захват CPU теперь поддерживается на FreeBSD и

Windows, используя Приоритетизация потока теперь доступна, управляется новым параметром

Параметр Разделение больше 16 ГБ.

Из-за улучшения внедрения индекса хэша, используемого узлами данных,

разделения таблиц Печать SQL-операторов от ndb_restore.

NDB 7.5.4 добавляет опцию

См.

раздел 6.24. Организация пакетов RPM.

С NDB 7.5.4 обозначение и организация пакетов RPM NDB Cluster

выравнивают более тесно с выпущенными для сервера MySQL. Названия всех

NDB Cluster RPM теперь имеют префикс

Для подробного списка NDB Cluster RPM и другой информации посмотрите

раздел 4.3.2. Таблицы ndbinfo processes и config_nodes.

NDB 7.5.7 добавляет две таблицы к информационной база данных

The

Имя системы.

Имя системы кластера NDB может использоваться, чтобы определить определенный

кластер. Начиная с NDB 7.5.7, MySQL Server показывает это имя как значение

переменной статуса

Имя системы дается на основе времени, когда сервер управления был начат.

Можно отвергнуть это значение, добавив раздел

Опции ndb_restore. С NDB 7.5.13 опции

Изменения в ndb_blob_tool. С NDB 7.5.18, the

ndb_blob_tool

может обнаружить недостающие части blob, для которых действующие части

существуют и заменяют их частями заполнителя (состоящего из пробелов)

правильной длины. Чтобы проверить наличие частей используйте опцию

См. раздел 6.6

. NDB Cluster 7.5 также поддерживается MySQL Cluster Manager,

который обеспечивает современный интерфейс командной строки, который может

упростить многие сложные задачи управления NDB Cluster. См.

MySQL Cluster Manager 1.4.8 User Manual. Новые особенности и другие важные изменения в NDB Cluster 7.6, которые,

вероятно, будут представлять интерес, показывают в следующем списке: Новый формат файла таблиц Disk Data.

Новый формат файла был введен в NDB 7.6.2 для таблиц NDB Disk Data,

который позволяет каждой таблице быть однозначно определенной, не используя

снова ID таблицы. Формат был улучшен далее в NDB 7.6.4.

Это должно помочь решить вопросы со страницей и обработкой экстента, которые

были видимы пользователю как проблемы с быстрым созданием и удалением таблиц

Disk Data, для которых старый формат не обеспечил готовое средство. Новый формат теперь используется каждый раз, когда новый файл журнала

отмен и файлы данных табличного пространства создаются. Файлы, касающиеся

существующих таблиц, продолжают использовать старый формат, пока их табличные

пространства и группы файла журнала отмен не воссоздаются. Старые и новые форматы несовместимы,

различные файлы данных или журнала отмен, которые используются той же самой

таблицей, или табличное пространство не могут

использовать соединение форматов. Чтобы избежать проблем, касающихся изменений в формате, необходимо

воссоздать любые существующие табличные пространства и группы журнала отмен,

модернизируя до NDB 7.6.2 или NDB 7.6.4. Можно сделать это, выполнив

начальный перезапуск каждого узла данных (то есть, используя

При использовании таблицы Disk Data переход от

любого выпуска NDB 7.6

безотносительно к какому статусу выпуска NDB 7.5 или ранее

требует, чтобы вы перезапустили все узлы данных с опцией

См.

раздел 4.9. Объединение памяти данных и динамическая память индекса.

Память, требуемая для индексов на столбцах таблицы

Начиная с NDB 7.6.2, если Кроме того, значение по умолчанию для

Объединение вместе памяти индекса с памятью данных упрощает конфигурацию

Как часть этой работы, много экземпляров

Поэтому может быть необходимо на некоторых системах увеличить

Кроме того, узлы данных теперь производят события

Другие связанные изменения перечисляются здесь: Таблица

ndbinfo и таблица config_nodes.

NDB 7.6.2 добавляет две таблицы к информационной база данных

Имя системы. Имя системы NDB cluster

может использоваться, чтобы определить кластер. Начиная с NDB 7.6.2, MySQL

Server показывает это имя как значение переменной статуса

Имя системы произведено автоматически на основе времени, когда сервер

управления был запущен, можно отвергнуть это значение, добавив раздел

Улучшенный инсталлятор GUI.

NDB Cluster Auto-Installer был изменен во многих отношениях, как

описано в следующем списке: Инсталлятор теперь обеспечивает постоянное хранение в

зашифрованном файле Установщик теперь использует безопасные связи (HTTPS) по умолчанию

между клиентом браузера и бэкендом веб-сервера. Библиотека безопасности Paramiko, использовавшаяся инсталлятором, была

модернизирована до версии 2. Другие улучшения функциональности установщика

SSH включают способность использовать пароли для зашифрованных закрытых

ключей и использовать различные параметры

авторизации с различными хостами. Поиск информации о хосте

был улучшен, и инсталлятор теперь предоставляет точные значения

для суммы дискового пространства, доступного на хостах. Конфигурация была улучшена с большинством параметров узла, теперь

доступных для урегулирования в GUI. Кроме того, параметрам, чьи разрешенные

значения перечислены, показали те значения

для выбора, устанавливая их. Также теперь возможно переключить

показ продвинутых параметров конфигурации на глобальной основе или на узел.

См. раздел 4.2. ndb_import CSV.

ndb_import,

добавлена в NDB Cluster 7.6.2, загружает CSV отформатированные данные

непосредственно в таблицу Предполагая, что база данных и целевая таблица

См. раздел 6.14

. ndb_top.

Добавлена утилита

ndb_top,

которая показывает загрузку ЦП и информацию об использовании для

узла данных

ndb_top

соединяется с узлом SQL в NDB Cluster (с MySQL Server).

Поэтому программа должна быть в состоянии соединиться как пользователь

MySQL, имеющий право

ndb_top

доступна для Linux, Solaris и macOS с NDB 7.6.3.

Это в настоящее время недоступно для платформ Windows. См. раздел 6.30

. Кодовая очистка. Значительное количество отладочных операторов,

не необходимых для нормального функционирования, было перемещено в код,

используемый только, проверяя или отлаживая

Поток LDM и улучшения LCP.

Ранее, когда местный поток управления данными испытывал

задержку I/O, он писал местные контрольные точки более медленно.

Это могло произойти, например, во время дисковой перегрузки.

Проблемы могли произойти, потому что другие потоки LDM не всегда наблюдали

это состояние или делали аналогично.

Ошибочная идентификация NDB.

Сообщения об ошибках и информация могут быть получены, используя клиент

mysql в NDB 7.6.4 и позже

из новой таблицы

Улучшения SPJ.

Выполняя просмотр как выдвинутое соединение (то есть, корень запроса

это просмотр), блок Теперь Эта работа, как ожидают, увеличит производительность

выдвинутых соединений по следующим причинам: Так как многократные корневые фрагменты

могут быть просмотрены для каждого запроса SPJ, необходимо запросить меньше

экземпляров SPJ, выполняя выдвинутое соединение. Увеличенное доступное пакетное распределение размера для каждого

фрагмента должно также в большинстве случаев привести к меньшему количеству

запросов, необходимых, чтобы закончить соединение. Улучшенная обработка O_DIRECT для журналов отката.

NDB 7.6.4 вводит новый параметр конфигурации узла данных

Необходимо принять во внимание, что урегулирование для этого параметра

проигнорировано, когда по крайней мере одно из следующих условий верно: Захват CPU потоком построения оффлайновых индексов.

В NDB 7.6.4 и позже поток построения оффлайновых индексов по умолчанию

использует все ядра, доступные

ndbmtd

вместо того, чтобы быть ограниченным одним ядром, зарезервированным для

потока I/O. Также становится возможно определить желаемый набор ядер, которые

будут использоваться для потоков I/O многопоточного построения

оффлайн индексов. Это может улучшить перезапуск, время и

производительность восстановления, а также доступность. Offline как используется здесь,

относится к построению индексу, который происходит в то время, как данная

таблица не пишется. Такой индекс создается во время узлового или системного

перезапуска или восстанавливая кластер из резервной копии, используя

ndb_restore

Это улучшение включает несколько связанных изменений.

Первое из них должно изменить значение по умолчанию для параметра

Как часть этой работы, NDB 7.6.4 также вводит параметр Переменные пакетные размеры для операций DDL по данным.

Как часть работы, продолжающейся, чтобы оптимизировать большую часть

работы DDL

ndbmtd,

теперь возможно получить повышения производительности, увеличивая пакетный

размер для оптовых частей данных операций DDL,

обрабатывающих данные, используя просмотры.

Пакетные размеры теперь сделаны конфигурируемыми для создания уникального

индекса, создания внешних ключей

и онлайн-перестройки, устанавливая соответствующие параметры конфигурации

узла данных, перечисленные здесь:

Для каждого из перечисленных параметров

значение по умолчанию равняется 64, минимум равняется 16, максимум 512. Увеличение соответствующего пакетного размера или размеров может помочь

уменьшить времена ожидания междоузлия и использовать больше параллельных

ресурсов, чтобы помочь масштабировать работу DDL. В каждом случае может быть

согласование с продолжающимся трафиком. Частичные LCP.

NDB 7.6.4 вводит частичные местные контрольные точки. Раньше LCP всегда делал

копию всей базы данных. Работая с терабайтами данных, этот процесс мог

потребовать большого количества времени с неблагоприятным воздействием на

узел и перезапуски кластера, а также больше пространства для журналов отката.

Теперь LCP по умолчанию сохраняет только много записей, которые основаны на

количестве данных, измененных начиная с предыдущего LCP.

Это может измениться между полной контрольной точкой и контрольной точкой,

которая не изменяет ничего вообще.

Если контрольная точка отражает любые изменения, как минимум надо написать

одну часть в 2048 байта, составив местный LCP. Как часть этого изменения, два новых параметра конфигурации узла данных

добавлены:

Необходимо отключить частичный LCP явно, установив

Значение по умолчанию для Кроме того, параметры конфигурации узла данных

Как часть этого улучшения, работа была сделана, чтобы исправить несколько

проблем с перезапусками узла, где

было возможно исчерпать журнал отмен

в различных ситуациях, чаще всего восстанавливая узел, который

долго был выключен в период интенсивных записей. Дополнительная работа была сделана, чтобы улучшить выживание узла данных

в длительные периоды синхронизации, обновив контрольный модуль

LCP во время этого процесса и отслеживая прогресс дисковой синхронизации

данных. Ранее, была возможность поддельных предупреждений или даже неудач

узла, если синхронизация заняла больше времени, чем защитный тайм-аут LCP. Модернизируя NDB Cluster, который использует дисковые таблицы данных для

NDB 7.6.4 или снижаясь от NDB 7.6.4 необходимо перезапустить все узлы

данных с

Параллельная обработка записей журнала отмены.

Раньше ядерный блок Количество записей журнала для каждого LDM в

Несколько типов записей продолжают обрабатываться последовательно:

Нет никаких видимых пользователем изменений в функциональности,

непосредственно связанной с этим исполнительным улучшением,

это часть работы, сделанной, чтобы улучшить длительную обработку журналов и

поддержку частичных местных контрольных точек в NDB Cluster 7.6.4. Чтение таблиц и ID фрагментов из экстента для журнала отмены.

Применяя журнал отмен, необходимо получить ID таблицы

и ID фрагмент со страницы ID. Это было сделано ранее, читая страницу

из ядерного блока Используя См. описание

Улучшения в NDB Cluster Auto-Installer.

В NDB 7.6.4 параметры конфигурации узла, их значения по умолчанию и их

документация в Auto-Installer были приведены в соответствие с NDB Cluster.

Поддержка SSH и конфигурация были также улучшены. Кроме того, HTTPS теперь

используется по умолчанию для веб-подключений и больше не используются

cookies как постоянный механизм хранения данных. Больше информации об этих и

других изменениях в Auto-Installer дано в следующих нескольких параграфах. Auto-Installer теперь осуществляет механизм для урегулирования параметров

конфигурации, которые берут дискретные значения. Например, параметр узла

данных Auto-Installer также теперь получает и показывает сумму дискового

пространства, доступного на хосте (как

Поддержка безопасного соединения в автоинсталляторе MySQL NDB Cluster

Auto-Installer была обновлена или улучшена в NDB Cluster 7.6.4: Добавлен механизм для урегулирования членства SSH

для каждого хоста. Обновлен модуль Paramiko Python до

последней доступной версии (2.6.1). Добавлено место в GUI для зашифрованных паролей с закрытым ключом и

прекращено использование жестко заданных паролей с

Другие улучшения, касающиеся безопасности данных, которые осуществляются в

NDB 7.6.4, включают следующее: Прекращено использование cookies для хранения информации

конфигурации NDB Cluster, они не были безопасны и шли с большим

верхним пределом хранения. Теперь автоустановщик использует зашифрованный

файл с этой целью. Чтобы обеспечить передачу данных между фронтэндом JavaScript в

веб-браузере пользователя и веб-сервером Python на бэкэнде, коммуникационный

протокол по умолчанию для этого был переключен от HTTP на HTTPS. См.

раздел 4.1. Транспортер общей памяти. Определенная пользователями общая

память (SHM) связи между узлом данных и узлом API на том же самом компьютере

поддерживается в NDB 7.6.6 и позже и больше не считается экспериментальной.

Можно позволить явное сопряжение с общей памятью, установив

Выполнение связей SHM может быть увеличено посредством установки

параметров

Параметр См.

раздел 5.3.12. Оптимизация внутреннего объединения в блоке SPJ.

В NDB 7.6.6 и позже ядерный блок Рассмотрите этот запрос соединения, где Ранее это привело бы к запросу Эта оптимизация не может быть применена, пока все узлы данных и все узлы

API в группе не были модернизированы до NDB 7.6.6 или позже. Пробуждение потоков NDB.

NDB 7.6.6 и более поздние поддерживают выгружаемые

потоком приемника задачи пробуждения других потоков к новому потоку, который

будит другие потоки по запросу (иначе просто спит),

позволяя улучшить производительность единственной связи примерно на

десять-двадцать процентов. Адаптивное управление LCP.

NDB 7.6.7 реализует адаптивный механизм управления LCP, который действует в

ответ на изменения в использовании пространства журнала отката.

Контролируя скорость записи на диск LCP, можно помочь защитить от многих

связанных с ресурсом проблем, включая следующее: Недостаточные ресурсы CPU для приложений. Дисковая перегрузка. Недостаточный буфер журнала отката. Условия остановки GCP. Недостаточное место журнала отката. Эта работа включает следующие изменения, касающиеся параметров

конфигурации Значение по умолчанию

Новый параметр конфигурации узла данных

Эта работа осуществляет контроль скорости LCP в основном, чтобы

минимизировать риск исчерпывания журнала отката. Это сделано адаптивным

способом, на основе суммы использованного пространства журнала отката,

используя аварийные уровни, с ответами, взятыми, когда

эти уровни достигнуты: Low:

использование пространства дурнала отката больше, чем на 25%, или оцененное

использование показывает недостаточное пространство журнала отката при очень

высокой скорости обработки транзакций.

В ответ использование буферов данных LCP увеличено во время просмотров LCP,

приоритет просмотров LCP увеличен, и объем данных, который может быть написан

за перерыв в реальном времени в просмотре LCP, также увеличен. High:

использование пространства журнала отката больше, чем 40%, ожидается

высокая вероятность исчерпать пространство журнала отката при высокой

скорости обработки транзакций. Когда этот уровень использования достигнут,

Critical:

использование пространства журнала отката больше 60%, или оцененное

использование показывает недостаточное пространство журнала отката при

нормальной скорости обработки транзакций. На этом уровне

Подъем уровня также имеет эффект увеличения расчетной целевой

скорости контрольной точки. Контроль LCP обладает следующими преимуществами для установки

Кластеры должны теперь пережить очень большие нагрузки,

используя конфигурации по умолчанию намного лучше, чем ранее. Должно теперь быть возможно для Опции ndb_restore.

С NDB 7.6.9

Восстановление частями.

С NDB 7.6.13 возможно разделить резервную копию на примерно равные части

и восстановить эти части в параллели, используя две новых опции,

осуществленные для

ndb_restore:

Это позволяет использовать многократные экземпляры

ndb_restore, чтобы

восстановить подмножества резервной копии параллельно, потенциально уменьшая

количество времени, требуемое, чтобы выполнить операцию восстановления. См. описания опций

ndb_restore и

Улучшения ndb_blob_tool.

С NDB 7.6.14

ndb_blob_tool

может обнаружить недостающие части blob, для которых действующие части

существуют и заменить их частями заполнителя (состоящих из пробелов)

правильной длины. Чтобы проверить, есть ли такие части, используйте опцию

См.

раздел 6.6. Этот раздел содержит информацию о параметрах конфигурации

Следующие параметры конфигурации узла были добавлены в NDB 7.5. Следующие параметры конфигурации узла устарели в NDB 7.5. Следующие параметры конфигурации узла были удалены в NDB 7.5. Никакие системные переменные, переменные статуса или опции

не устарели в NDB 7.5. Ничего не удалено в NDB 7.5. Следующие параметры конфигурации узла были добавлены в NDB 7.6. Нет таких в NDB 7.6. Ничего не устарело. Ничего не удалено. MySQL Server предлагает много выбора в механизмах хранения.

Начиная с обоих В этой секции мы обсуждаем и сравниваем некоторые особенности

NDB Cluster 7.5 тспользует mysqld

на основе MySQL 5.7, включая поддержку

Также верно, что некоторыми типами общих бизнес-приложений можно управлять

в NDB Cluster или MySQL Server (скорее всего, используя

Для получения информации об относительных особенностях механизмов

См. Alternative Storage Engines

для получения дополнительной информации о механизмах хранения MySQL. Механизм хранения Таблица 3.1.

Различия между InnoDB и NDB NDB Cluster имеет диапазон уникальных признаков, которые делают ее

идеалом, чтобы служить запросам, требующим высокой доступности, быстрой

отказоустойчивости, высокой пропускной способности и низкого времени

ожидания. Из-за распределенной архитектуры и внедрения мультиузлов, у NDB

Cluster также есть определенные ограничения, которые могут помешать некоторой

рабочей нагрузке. Много существенных различий в поведении между

Таблица 3.2. Различия между механизмами хранения InnoDB и NDB с

общими типами управляемых данными рабочих нагрузок приложений. Сравнивая требования функции приложения с возможностями

В следующей таблице перечислены особенности поддерживаемого приложения,

согласно механизму хранения, к которому, как правило, лучше

подходит каждая особенность. Таблица 3.3. Поддерживаемые возможности приложений

согласно механизму хранения, к которому, как правило, лучше

подходит каждая особенность Внешние ключи NDB Cluster 7.5 поддерживает внешние ключи Полное сканирование таблицы Очень большие базы данных, строки или транзакции Транзакции кроме

Масштабирование записи 99.999% uptime Добавление онлайн узлов и операции по схеме онлайн Многократные SQL и NoSQL API (см.

NDB Cluster APIs: Overview and Concepts) Работа в реальном времени Ограниченное использование столбцов

Внешние ключи поддерживаются, хотя их использование может оказать

влияние на работу на высокой пропускной способности

В секциях, которые следуют, мы обсуждаем известные ограничения в

текущих выпусках NDB Cluster по сравнению с особенностями, доступными,

используя NDB Cluster Cluster Direct API (NDBAPI) Cluster Disk Data Cluster Replication ClusterJ См. Previous NDB Cluster Issues Resolved in NDB Cluster 8.0

для получения списка проблем в более ранних выпусках, которые были решены в

NDB Cluster 7.5. Ограничения и другие проблемы, определенные для NDB Cluster Replication,

описаны в

разделе 8.3. Некоторые SQL-операторы, касающиеся определенных особенностей MySQL,

производят ошибки, когда используются с

Временные таблицы. Временные таблицы не поддерживаются.

Попытка составить временную таблицу, которая использует

Индексы и ключи в таблицах NDB.

Ключи и индексы на таблицах NDB Cluster

подвергаются следующим ограничениям: Ширина столбца. Попытка создать индекс на столбце таблицы

Столбцы TEXT и BLOB. Вы не можете создать индексы на столбцах

Индексы FULLTEXT.

Однако можно создать индексы на столбцах

Ключи USING HASH и NULL. Используя nullable колонки в

уникальных ключах и первичные ключи, запросы, использующие эти колонки,

обработаны как полное сканирование таблицы. Чтобы обойти эту проблему,

сделайте колонку Префиксы. Нет никаких индексов префикса,

только все колонки могут быть внесены в индекс. Размер индекса столбца

Столбцы BIT.

Столбцы Столбцы AUTO_INCREMENT. Как другие механизмы

хранения MySQL, Ограничения на внешние ключи.

Поддержка ограничений внешнего ключа в NDB 7.5 сопоставима с обеспеченной

Каждая колонка, на которую ссылаются как внешний ключ, требует

явного уникального ключа, если это не первичный ключ таблицы. Это вызвано тем, что обновление первичного ключа осуществляется как

удаление старой строки (содержащей старый первичный ключ) плюс вставка новой

строки (с новым первичным ключом). Это невидимо ядром

С NDB 7.5.14 и NDB 7.6.10: Ключевые слова В более ранних версиях NDB Cluster, составляя таблицу с внешним

ключом, ссылающимся на индекс в другой таблице, иногда казалось возможным

создать внешний ключ, даже если порядок колонок в индексах не соответствовал,

вследствие того, что соответствующая ошибка не всегда возвращалась внутренне.

Частичная фиксация для этой проблемы улучшилась, ошибка раньше внутренне

работала в большинстве случаев, однако, эта ситуация остается возможной,

если родительский индекс уникальный (Bug #18094360). До NDB 7.5.6, добавляя или удаляя использование внешнего ключа

Эта проблема устраняется в NDB 7.5.6 (Bug #82989, Bug #24666177).

NDB Cluster и типы данных геометрии.

Типы данных геометрии

( Наборы символов и двоичные файлы журнала.

Сейчас таблицы Используйте только символы Latin-1, называя двоичные файлы журнала или

устанавливая любые опции

Создание таблиц NDB с определенным пользователями разделением.

Поддержка определенного пользователями разделения в NDB Cluster

ограничивается разделением [ Возможно отвергнуть это ограничение, но выполнение этого

не поддерживается для использования в производственных параметрах настройки.

Для получения дополнительной информации посмотрите

see User-defined partitioning and the NDB storage

engine (NDB Cluster). Схема выделения разделов по умолчанию. Все таблицы NDB Cluster

по умолчанию разделены У таблицы должен быть явный первичный ключ. Все колонки, перечисленные в выражении разделения таблицы, должны быть

частью первичного ключа. Исключение. Если разделенная пользователями таблица

Максимальное количество разделов для таблиц NDBCLUSTER.

Максимальное количество разделов, которое может быть определено для таблиц

DROP PARTITION не поддерживается. Невозможно исключить раздел из

таблиц Построчная репликация.

Используя построчную

репликацию с NDB Cluster, двоичная регистрация не может быть отключена.

Таким образом, механизм хранения Тип данных JSON.

Тип данных MySQL Таблицы NDB API не имеет специального положения для работы с данными

Таблицы информации о CPU и потоках в ndbinfo.

NDB 7.5.2 добавляет несколько новых таблиц в БД

Для получения дополнительной информации об этих таблицах, посмотрите

раздел 7.10. Таблицы информации о блокировках в ndbinfo.

NDB 7.5.3 добавляет новые таблицы к БД

В этой секции мы перечисляем пределы NDB Cluster, отличающиеся

от обычного MySQL. Использование памяти и восстановление.

Память потребленная, когда данные вставляются в таблицу

A Катящийся перезапуск группы также освобождает любую память, используемую

удаленными строкими. Посмотрите

раздел 7.5. Ограничения, наложенные конфигурацией группы.

Много жестких пределов существуют, которые являются конфигурируемыми,

но ограничены доступной оперативной памятью. См. полный список параметров

конфигурации в разделе

5.3. Большинство параметров конфигурации может быть модернизировано

онлайн. Эти жесткие пределы включают: Емкость памяти базы данных и емкость памяти индекса

(

См.

раздел 5.3.6. Максимальное число операций, которые могут быть выполнены за

транзакцию, определяется, используя параметры конфигурации

Оптовая загрузка,

Различные пределы связаны с таблицами и индексами. Например,

максимальное количество заказных индексов в группе определяется

Узел и максимумы объекта данных.

Следующие пределы относятся к числам узлов группы и объектов метаданных: Максимальное количество узлов данных равняется 48. У узла данных должен быть ID узла в диапазоне 1-48 включительно.

Управление и узлы API могут использовать ID

узла в диапазоне 1-255 включительно. Полное максимальное количество узлов в NDB Cluster 255.

Это число включает все узлы SQL (MySQL Server), API,

данных и серверы управления. Максимальное количество объектов метаданных в текущих версиях NDB

Cluster 20320. Этот предел жестко закодирован. См. Previous NDB Cluster Issues Resolved in NDB Cluster 8.0.

Много ограничений существуют в NDB Cluster

относительно обработки транзакций. Они включают следующее: Уровень изоляции транзакции.

Нейтральные данные никогда не возвращаются, но когда транзакция,

изменяющая много строк, работает одновременно с транзакцией, читающей те же

самые строки, транзакция, выполняющая чтение, может наблюдать вместе

значения до и после

для различных строк среди них, вследствие того, что данный запрос чтения

может быть обработан прежде или после передачи другой транзакции. Чтобы гарантировать, что данная транзакция читает только значения прежде

или после, можно наложить использование блокировок строки

Увеличенная частота блокировки ждет ошибки из-за

тайм-аута и уменьшает параллелизм. Увеличение издержек обработки транзакций

из-за чтения, ждущего фазы передачи. Возможность истощения доступного количества параллельных

блокировок, которое ограничивается

См.

раздел 7.3.4 для получения информации о том, как уровни изоляции

транзакции в NDB Cluster могут затронуть резервную копию и восстановление

баз данных Транзакции и столбцы BLOB или TEXT.

Для любого

Для любого

Эта проблема не происходит для запросов, которые используют индекс или

сканирование таблицы, даже для таблиц

Например, рассмотрите таблицу Любой из следующих запросов на Однако, ни один из четырех запросов, показанных здесь, не вызывает

общую блокировку чтения: Это вызвано тем, что из этих четырех запросов первый применяет

просмотр индекса, второй и третий сканирование таблицы, а

четвертый, используя поиск первичного ключа, не получает значение никакого

Можно помочь минимизировать проблемы с общими блокировкими чтения,

избежав запросов, которые используют поиски уникального ключа,

которые получают Обратные перемотки. Нет никаких частичных транзакций и никаких

частичных обратных перемоток транзакций. Дублирование ключа или подобная

ошибка заставляет всю транзакцию быть отмененной до прежнего уровня. Это поведение отличается от других механизмов системы

хранения транзакций, например,

Транзакции и использование памяти.

Как отмечено в другом месте в этой главе, NDB Cluster

не обращается с большими транзакциями хорошо, лучше выполнить много маленьких

транзакций с несколькими операциями каждая, чем делать попытку единственной

большой транзакции, содержащей очень много операций. Среди других соображений

большие транзакции требуют очень больших объемов памяти. Из-за этого

транзакционное поведение многих запросов MySQL затронуто, как

описано в следующем списке: LOAD DATA.

При выполнении

ALTER TABLE и транзакции.

Копируя таблицу Транзакции и функция COUNT().

При использовании NDB Cluster Replication

невозможно гарантировать согласованность транзакций и функции

Запуская, останавливая или перезапуская узел можно дать начало

нерегулярным ошибкам, заставляющим некоторые транзакции потерпеть неудачу.

Они включают следующие случаи: Нерегулярные ошибки..

Сначала начиная узел, возможно, что можно видеть Error 1204

Temporary failure, distribution

changed и подобные нерегулярные ошибки. Ошибки из-за неудачи узла.

Остановка или неудача любого узла данных могут привести ко многим различным

ошибкам неудачи узла. Однако, не должно быть никаких прерванных транзакций,

выполняя запланированное закрытие кластера. В любом из этих случаев любые ошибки, которые произведены, должны быть

обработаны в приложении. Это должно быть сделано, повторив транзакцию. См.

раздел 3.7.2. У некоторых объектов базы данных, таких как таблицы и индексы, есть

различные ограничения, используя

Имена базы данных и имена таблиц.

Используя Количество объектов базы данных.

Максимальное количество всех

объекты базы данных

Признаки на таблицу.

Максимальное количество признаков (то есть, колонок и индексов), которое

может принадлежать данной таблице, 512. Признаки на ключ.

Максимальное количество признаков на ключ равняется 32. Размер строки.

Максимальный разрешенный размер любой строки составляет 14000 байтов. Каждый столбец Кроме того, максимальное смещение для столбца фиксированной ширины

в Столбцы BIT на таблицу.

Максимальная объединенная ширина для всех столбцов

Хранение колонки FIXED.

NDB Cluster 7.5 и более поздние поддерживают

максимум 128 TB на фрагмент данных в столбцах

Много функций, поддержанных другими механизмами хранения, не

поддерживаются для Префиксы индекса.

Префиксы на индексах не поддерживаются для

Запрос, содержащий префикс индекса, и создающий или изменяющий таблицу

Это происходит вследствие правила синтаксиса SQL, что ни у какого индекса

не может быть префикса больше, чем он сам. Точки сохранения и обратные перемотки.

Точки сохранения и обратные перемотки к точкам сохранения проигнорированы,

как в Длительность передачи.

Нет длительности передачи на диске. Передачи копируются, но нет никакой

гарантии, что журналы сбрасываются на диск при передаче. Репликация. Основанная на запросе репликация

не поддерживается. Используйте

Репликация используя глобальные идентификаторы транзакции (GTID)

несовместима с NDB Cluster 7.5 или NDB CLuster 7.6.

Не позволяйте GTID, используя Полусинхронная репликация не поддерживается в NDB Cluster. Произведенные колонки.

Как с другими механизмами хранения, можно создать индекс на сохраненной

произведенной колонке, но необходимо принять во внимание, что

NDB Cluster пишет изменения в сохраненных произведенных колонках к

двоичному журналу регистрации, но не регистрирует сделанные виртуальные

колонки. Это не должно производиться NDB Cluster Replication или

репликацией между См.

раздел 3.7.3 для получения дополнительной информации касающийся

ограничений на операционную обработку в

Следующие исполнительные проблемы определены для NDB Cluster: Просмотры диапазона.

Есть проблемы производительности запросов из-за последовательного доступа к

Надежность записей в диапазоне.

Статистика Уникальные индексы хэша. Уникальные индексы хэша, созданные

Следующее ограничения, определенные для механизма хранения

Машинная архитектура.

У всех машин, используемых в группе, должна быть та же самая архитектура.

Таким образом, все машины, принимающие узлы, должны быть с одним и тем же

порядком байтов, вы не можете использовать их смесь.

Например, у вас не может быть узла управления на PowerPC,

который направляет узел данных на x86. Это ограничение не относится к

машинам, выполняющим mysql

или другим клиентам, которые могут получать доступ к узлам SQL. Двоичный журнал.

NDB Cluster имеет следующие ограничения относительно двоичной регистрации:

NDB Cluster не может произвести двоичную регистрацию для таблиц с

Только следующие операции по схеме вошли в двоичную регистрацию

группы, которая не выполняет запросы

mysqld: Операции по схеме. Операции по схеме (запросы DDL) отклонены в

то время, как любой узел данных перезапускается. Операции по схеме также не

поддерживаются, выполняя модернизацию онлайн или удаление. Количество точных копий. Количество точных копий, как

определено параметром конфигурации узла данных

Урегулирование

См.

раздел 3.7.10. Дисковые максимумы и минимумы объекта данных.

Дисковые объекты данных подвергаются следующим максимумам и минимумам: Максимальное количество табличных пространств:

232 (4294967296). Максимальное количество файлов данных на табличное пространство:

216 (65536). Минимальные и максимальные возможные размеры экстентов для файлов

данных табличного пространства 32K и 2G, соответственно. Посмотрите

CREATE TABLESPACE Statement. Кроме того, работая с таблицами NDB Disk Data,

необходимо знать следующие проблемы файлов данных и экстентов: Файлы данных используют

Файлы данных используют дескрипторы файлов. Важно иметь в виду, что

файлы данных всегда открыты, что означает, что дескрипторы файлов всегда

используются и не могут быть снова использованы для

других системных задач. Экстенты требуют достаточной

Таблицы Disk Data и бездисковый режим.

Использование таблиц Disk Data не поддерживается в бездисковом режиме. Много узлов SQL.

Следующее это проблемы, касающиеся использования многократных серверов MySQL

как узлов SQL NDB Cluster для

Никаких распределенных блокировок таблицы.

Операции ALTER TABLE.

Многократные узлы управления.

Используя многократные серверы управления: Если какой-либо из серверов управления работает на том же самом

хосте, необходимо дать узлам явные ID в строках подключения, потому что

автоматическое распределение ID узла не работает через многократные серверы

управления с тем же самым хостом. Это не требуется, если каждый сервер

управления работает на своем хосте. Когда сервер управления запускается, он сначала проверяет на любой

другой сервер управления в том же самом NDB Cluster

и после успешной связи с другим сервером управления использует его данные

конфигурации. Это означает, что опции запуска сервера управления

Многократные сетевые адреса. Многократные сетевые адреса на

узел данных не поддерживаются. Использование их склонно вызвать проблемы: в

случае неудачи узла данных узел SQL ждет подтверждения, что узел данных

отвалился, но никогда не получает его, потому что другой маршрут к тому узлу

данных остается открытым. Это может эффективно сделать кластер нерабочим. Возможно использовать многократные сетевые

аппаратные интерфейсы (например,

карты Ethernet) для единственного узла данных, но они должны быть связаны с

тем же самым адресом. Это также означает, что невозможно использовать больше

одного раздела

Глава 3. Обзор NDB Cluster

NDB (сокращение от

Network

Data

Base). В нашей документации термин

NDB

относится к части установки, которая является определенной для

хранения, тогда как MySQL NDB Cluster

относится к комбинации одного или более серверов MySQL с механизмом

хранения NDB.

NDB,

таблицы (и данные о таблице) сохранены в узлах данных. Такие таблицы

непосредственно доступны от всех других серверов MySQL (узлы SQL) в группе.

Таким образом, в запросе на платежную ведомость, хранящем данные в группе,

если приложение обновило зарплату сотрудника, все другие серверы MySQL,

которые запрашивают эти данные, немедленно видят это изменение.NDB

и не может получить доступ ни к каким данным NDB Cluster.NDB

в клиенте управления NDB Cluster, программа

ndb_restore включена в

пакет NDB Cluster. См. разделы 7.3

и раздел 6.24

. Можно также использовать стандартную функциональность MySQL,

обеспеченную с этой целью в

mysqldump и сервер MySQL.

См. mysqldump.3.1. Понятия ядра NDB Cluster

NDBCLUSTER

(также NDB) это

механизм памяти, предлагающий особенности постоянства

данных и высокую доступность.NDBCLUSTER

может формироваться с диапазоном отказоустойчивости и вариантов выравнивания

нагрузки, но является самым легким начать с механизмом

хранения на уровне группы. В NDB Cluster механизм

NDB

содержит полный набор данных, зависящий только от других

данных в самой группе.NDBCLUSTER.

Узел SQL это процесс mysqld,

начатый с опциями

--ndbcluster и

--ndb-connectstring,

которые объяснены в другом месте в этой главе, возможно также с

дополнительными вариантами сервера MySQL.NDB API и клиенты управления.

Они описаны в следующих нескольких параграфах.jdbc:mysql:loadbalance:// (улучшено в

Connector/J 5.1.7), чтобы достигнуть выравнивания нагрузки прозрачно, для

получения дополнительной информации об использовании Connector/J с NDB

Cluster см. Using Connector/J with NDB Cluster.NDBCLUSTER, обходя любые MySQL Server, которые

могут быть связаны с группой, используя NDB

API, высокоуровневый C++ API. Такие запросы могут быть полезны для

специализированных целей, где интерфейс SQL к данным не необходим. Для

получения дополнительной информации посмотрите

The NDB API.NDB-Java приложения

могут также быть написаны для NDB Cluster с NDB

Cluster Connector for Java. NDB Cluster Connector включает

ClusterJ,

API высокого уровня, подобный структурам постоянства отображения

Hibernate и JPA, которые соединяются непосредственно с

NDBCLUSTER и не требует доступа к MySQL Server.

Поддержка также оказывается в NDB Cluster для

ClusterJPA, реализации OpenJPA для NDB

Cluster, которая усиливает преимущества ClusterJ и JDBC,

поиски ID и другие быстрые операции выполняются, используя ClusterJ

(обходя MySQL Server) в то время, как более сложные запросы, которые могут

извлечь выгоду из оптимизатора запросов MySQL, посылают через MySQL Server,

применяя JDBC. См.

Java and NDB Cluster и

The ClusterJ API and Data Object Model.NDB, а также для MySQL Server.

Запросы используя этот соединитель типично управляемы событиями и используют

модель объекта области, подобную во многих отношениях используемой ClusterJ.

См. MySQL NoSQL Connector for JavaScript.NDB

есть два типа контрольных точек, которые сотрудничают, чтобы

гарантировать, что сохраняется последовательное представление данных.

Их показывают в следующем списке:EnablePartialLcp и

RecoveryWork, которые позволяют частичный

LCP и управляют объемом хранения, который они используют.

3.2. Узлы NDB Cluster, группы узлов, точные копии и разделение

NoOfReplicas):

[число групп узлов] = [число узлов данных] /

NoOfReplicas

NoOfReplicas = 1 в

config.ini, 2 группы узлов, если

NoOfReplicas = 2 или 1 группа узлов, если

NoOfReplicas = 4. Точные копии обсуждены позже в этой секции,

для получения дополнительной информации о

NoOfReplicas см.

раздел 5.3.6.

[число разделов] = [число узлов данных] * [число потоков LDM]

MaxNoOfExecutionThreads.

При использовании

ndbd

есть единственный поток LDM, что означает, что есть столько же разделов,

сколько узлов в кластере. Это также имеет место, используя

ndbmtd с

MaxNoOfExecutionThreads = 3 или меньше

(необходимо знать, что количество потоков LDM растет с увеличением

этого параметра, но не строго линейным способом, и что есть дополнительные

ограничения, см. описание

MaxNoOfExecutionThreads).NDBCLUSTER сам.

Однако также возможно использовать определенное пользователями разделение с

таблицами NDBCLUSTER.

Это подвергается следующим ограничениям:KEY и

LINEAR KEY поддерживаются в производстве с

таблицами NDB.NDB,

8 * [, число групп узлов в NDB Cluster

определяется как обсуждено ранее в этой секции. При работе с

ndbd для процессов узла данных, определение числа

потоков LDM не имеют никакого эффекта (так как

число потоков LDM

] * [число групп узлов

]

ThreadConfig применяется только к

only to

ndbmtd),

в таких случаях можно рассматривать это значение

как будто это было равно 1 в целях выполнить это вычисление.

3.3. Требования NDB Cluster

HeartbeatIntervalDbDb и

HeartbeatIntervalDbApi для NDB Cluster,

можно достигнуть быстрого обнаружения, отказоустойчивости и возвратиться к

работе, избегая потенциально дорогих ложных сбоев.

3.4. Новое в NDB Cluster

3.4.1. Новое в NDB Cluster 7.5

ndbinfo, она теперь предоставляет подробную информацию о

параметрах конфигурации узла NDB Cluster.config_params

была сделана только для чтения и увеличена с дополнительными колонками,

предоставляющими информацию о каждом параметре конфигурации, включая тип

параметра, значение по умолчанию, максимальные и минимальные значения (где

применимы), краткое описание параметра и требуется ли параметр.

Эта таблица также предоставляет каждому параметру уникальный

param_number.config_values

показывает текущее значение данного параметра на узле, имеющем указанный ID.

Параметр определяется столбцом config_param,

который отображается к config_params

для param_number таблицы.

SELECT p.param_name AS Name, v.node_id AS Node, p.param_type AS Type,

p.param_default AS 'Default', p.param_min AS Minimum,

p.param_max AS Maximum,

CASE p.param_mandatory WHEN 1 THEN 'Y' ELSE 'N' END AS 'Required',

v.config_value AS Current FROM config_params p

JOIN config_values v ON p.param_number = v.config_param

WHERE p.param_name IN ('NodeId','HostName','DataMemory','IndexMemory');

ndbinfo

больше не зависит от механизма хранения MyISAM.

Все таблицы и представления ndbinfo

теперь используют NDB (показано как

NDBINFO).ndbinfo

были введены в NDB 7.5.4. Эти таблицы перечисляются

здесь с краткими описаниями:dict_obj_info

обеспечивает имена и типы объектов базы данных в

NDB, а также информацию о родительском объекте,

когда это применимо.table_distribution_status

обеспечивает информацию о статусе распределения таблицы

NDB.table_fragments

предоставляет информацию о распределении фрагментов таблицы

NDB.table_info

предоставляет информацию о регистрации, контрольных точках, хранении и

других параметрах для каждой таблицы NDB

.table_replicas

предоставляет информацию о точных копиях фрагмента.ROW_FORMAT и

COLUMN_FORMAT в

CREATE TABLE

могут быть установлены в DYNAMIC вместо

FIXED использованием новой серверной

переменной MySQL

ndb_default_column_format,

установите это в FIXED или

DYNAMIC (или начните

mysqld с эквивалентной опцией

--ndb-default-column-format=FIXED),

чтобы вынудить это значение использоваться для

COLUMN_FORMAT и

ROW_FORMAT. До NDB 7.5.4 умолчанием для этой

переменной было DYNAMIC,

в этой и более поздних версиях умолчание

FIXED, что

обеспечивает совместимость с предшествующими выпусками (Bug #24487363).ndb_default_column_format),

существующие столбцы изменяются, чтобы использовать их также, при условии,

что запрос ALTER TABLE, выполняющий эту

операцию, определяет ALGORITHM=COPY.ALTER TABLE

не может быть сделано неявно, если

mysqld работает с

--ndb-allow-copying-alter-table=FALSE

.ndb_binlog_index,

используемая в NDB Cluster Replication, применяет механизм хранения

InnoDB вместо

MyISAM. Модернизируя, можно управлять

mysql_upgrade с

--force

--upgrade-system-tables,

чтобы заставить его выполнить

ALTER TABLE ... ENGINE=INNODB

на этой таблице. Использование MyISAM

остается поддержанным для обратной совместимости.ALTER TABLE.

Это больше не поддерживается в NDB Cluster 7.5,

что делает исключительное использование

ALGORITHM = DEFAULT|COPY|INPLACE

для таблицы DDL, как в стандартном MySQL Server.ALTER TABLE ... ALGORITHM=INPLACE RENAME

теперь содержит операции DDL в дополнение к переименованию.ExecuteOnComputer для

узлов управления,

данных и

API

устарел и теперь подвергается удалению в будущем выпуске NDB Cluster.

Необходимо использовать эквивалент HostName

для всех трех типов узлов.EXPLAIN более точны.SHOW INDEX улучшены.

--ndb-cluster-connection-pool-nodeids,

которая позволяет некоторым ID узлов быть установленными для пула соединений.

Это урегулирование отвергает

--ndb-nodeid, что означает, что это также отвергает опцию

--ndb-connectstring и переменную окружения

NDB_CONNECTSTRING.--ndb-cluster-connection-pool для

mysqld.create_old_temporals устарела еще в

NDB Cluster 7.4 и наконец удалена.PROMPT

:

ndb_mgm>

PROMPT mgm#1:

mgm#1: SHOW

Cluster Configuration

---------------------

[ndbd(NDB)] 4 node(s)

id=5@10.100.1.1(mysql-5.7.29-ndb-7.5.17, Nodegroup: 0, *)

id=6@10.100.1.3(mysql-5.7.29-ndb-7.5.17, Nodegroup: 0)

id=7@10.100.1.9(mysql-5.7.29-ndb-7.5.17, Nodegroup: 1)

id=8@10.100.1.11(mysql-5.7.29-ndb-7.5.17, Nodegroup: 1)

[ndb_mgmd(MGM)] 1 node(s)

id=50 @10.100.1.8(mysql-5.7.29-ndb-7.5.17)

[mysqld(API)] 2 node(s)

id=100@10.100.1.8(5.7.29-ndb-7.5.17)

id=101@10.100.1.10(5.7.29-ndb-7.5.17)

mgm#1: PROMPT

ndb_mgm> EXIT

jon@valhaj:/usr/local/mysql/bin>

FIXED. В

NDB Cluster 7.4 и ранее это было 16 GB.Id: устарел в NDB 7.1.9, заменен

NodeId.NoOfDiskPagesToDiskDuringRestartTUP,

NoOfDiskPagesToDiskDuringRestartACC:

устарели, не имели никакого эффекта, заменены в MySQL 5.1.6 на

DiskCheckpointSpeedInRestart,

который самостоятельно позже устарел (в NDB 7.4.1) и теперь удален.NoOfDiskPagesToDiskAfterRestartACC,

NoOfDiskPagesToDiskAfterRestartTUP:

устарели, не имели никакого эффекта, заменены в MySQL 5.1.6 на

DiskCheckpointSpeed,

который самостоятельно позже устарел (в NDB 7.4.1) и теперь удален.ReservedSendBufferMemory: устарел в

NDB 7.2.5, больше не действует.MaxNoOfIndexes: старый (до MySQL

4.1), не работает, давно заменен

MaxNoOfOrderedIndexes или

MaxNoOfUniqueHashIndexes.Discless: старый (до MySQL 4.1)

давно заменен

Diskless.ByteOrder

был также удален в NDB 7.5.0.DBTC и

DBDIH в

NDB,

предоставляя возможность более высокой масштабируемости узлов данных, когда

используется для операций по просмотру, уменьшая использование ресурсов CPU

для операций по просмотру, в некоторых случаях приблизительно

на пять процентов.BACKUP были также улучшены и сделаны более

эффективными, чем в предыдущих выпусках.JSON для таблиц

NDB и функции JSON в MySQL Server,

согласно ограничению, что таблица

NDB может иметь самое большее 3 столбца

JSON.

ndb_read_backup.PARTITION_BALANCE

(FRAGMENT_COUNT_TYPE в NDB

7.5.4), включенной в комментарий NDB_TABLE в

CREATE TABLE или

ALTER TABLE.

Параметры настройки для уровня таблицы

READ_BACKUP также поддерживаются, используя этот

синтаксис. Для получения дополнительной информации и примеров посмотрите

Setting NDB_TABLE Options.ndb_data_node_neighbour.

Это предназначается для использования в операционных советах, чтобы

предоставить соседний

узел данных этому узлу SQL.--restore-meta

теперь использует разделение целевой группы по умолчанию вместо того, чтобы

использовать то же самое разделение, как оригинальная группа, от которой была

взята резервная копия. Посмотрите

раздел 6.24.1.2.READ_BACKUP: в

этой и более поздних версиях возможно установить

READ_BACKUP для данной таблицы онлайн как часть

ALTER TABLE ... ALGORITHM=INPLACE ...

.ThreadConfig, параметра конфигурации

многопоточного узла данных

(

ndbmtd),

включая поддержку увеличенного числа платформ. Эти изменения описаны